最后一篇ICLR在周四讲。

(加州时间周四4月28日下午6点半,北京时间周五4月29日上午9点半,Poster Session 12)

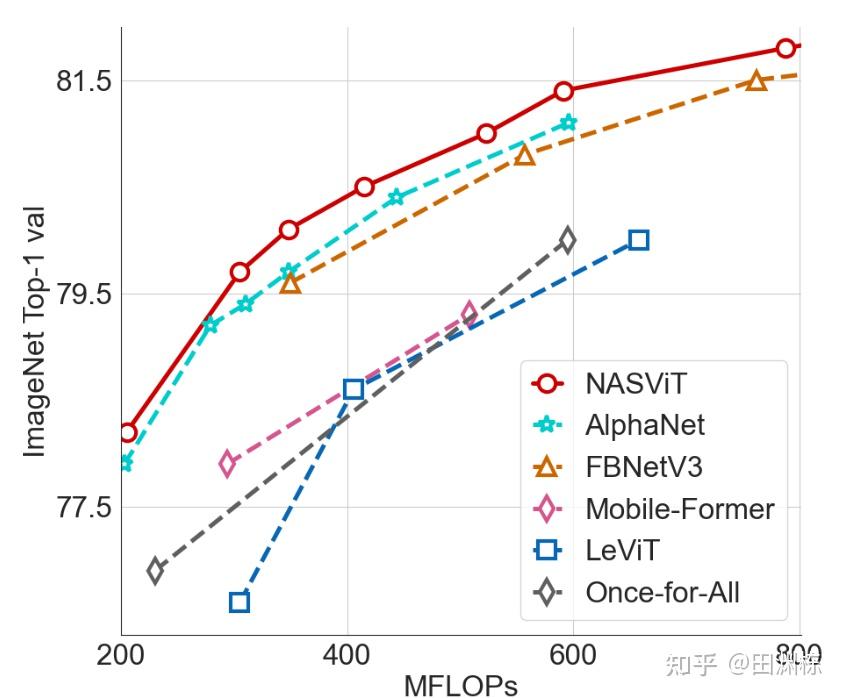

我们使用基于supernet的神经结构搜索(NAS)训练得到了一系列跟MobileNet一样轻量级(FLOPs位于200M到800M区间),同时精度更高的的ViT模型。在训练过程中,我们发现supernet中不同子网络之间的梯度容易互相冲突(gradient conflict),为止我们我们从搜索空间设计,optimizer优化和模型正则化的角度提出了多个方法降低不同子网络之间的梯度冲突的方法,并在ImageNet数据集上取得了优于当前的CNN和ViT模型的SOTA精度。

(感谢一作Chengyue Gong提供的文字稿)