全球首款搭载原创类脑算法的超小型移动式类脑智算体“智者一号”在广东横琴发布。该设备体积仅为传统超算的十分之一,却拥有1152个CPU核心、4.8TB内存和204TB存储,采用液冷散热。其核心技术为自主研发的“直觉神经网络”,能高效运行包括大模型在内的各类模型,具备可解释的推理过程和小样本、持续学习及多模态数据处理能力。与传统AI相比,“智者一号”的算法使其具备“说理能力”。现场演示显示,其在单个CPU节点上完成百亿token训练仅需30小时,训练和推理速度均媲美高端GPU集群,同时硬件成本降低约50%,能耗下降近90%。

🧠全球首款类脑智算体:'智者一号'是一款超小型、移动式的类脑智能计算设备,首次搭载了原创的'直觉神经网络'算法。

🚀高性能与低功耗:设备体积小巧,仅相当于迷你冰箱大小,但配置强大,拥有1152个CPU核心等高性能硬件,同时采用液冷散热,功耗和噪音都较低,易于部署在各种环境中。

💡核心技术突破:自主研发的'直觉神经网络'算法模拟人脑运算机制,实现了数值与符号统一的类脑学习网络,具备可解释的推理能力,解决了传统深度学习模型的黑箱问题,并支持小样本学习、持续学习和多模态数据融合。

💰成本与能效优势:'智者一号'在训练和推理速度上媲美传统GPU集群的同时,显著降低了硬件成本约50%,能耗也下降了近90%,使得高性能计算更贴近用户。

🌍广泛应用前景:该类脑智算体拥有完善的工具链,可用于金融、医疗、制造、家庭、教育等多个领域,提供个性化的智能应用,有望改变依赖远程算力中心的局面。

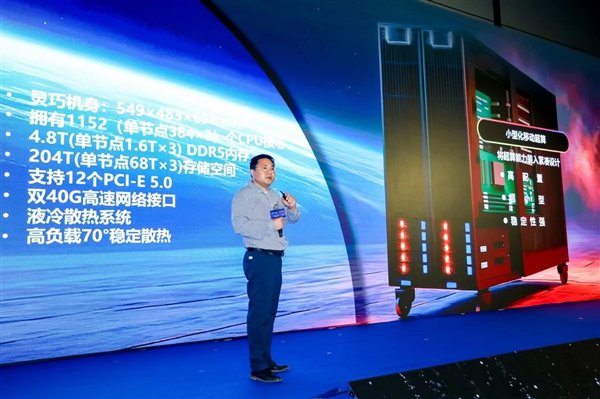

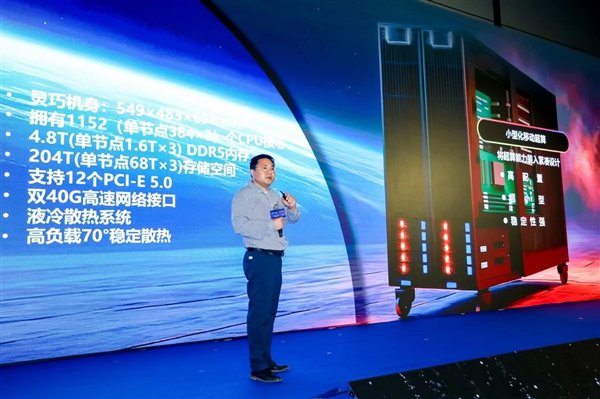

快科技10月28日消息,近日,在广东横琴粤澳深度合作区举办的“2025类脑智算论坛暨类脑智算创新产品发布会”上,全球首款搭乘原创类脑算法的超小型、移动式的类脑智算体“智者一号”(BI Explorer-1/BIE-1)正式亮相!

据介绍,“智者一号”拥有高配置、小体积、高稳定性,只有迷你单门冰箱大小,相当于传统超算设备的十分之一。

“智者一号”内部分为3个节点,总计拥有1152个CPU核心(具体型号不详)、4.8TB DDR5内存、204TB存储空间,还有12条PCIe 5.0总线、40G高速网络接口,采用液冷散热,复杂推理任务下的CPU温度也不超过70度。它可以轻松部署在家庭、小型办公室甚至移动环境中,低功耗、低噪音,堪称小型化超级计算机。

它的核心技术突破在于自主研发的独特类脑算法“直觉神经网络”(Intuitive Neural Network),缩写为INN,可以高速高效地运行包含大模型在内的各种模型训练与推理。INN具备可解释的数值与符号统一的类脑学习网络,高度模拟人脑运算机制,融合了符号计算与数据驱动的三值逻辑类脑模型,采用全新的“结构信息抽取—逻辑组网”架构机制,不仅能高效学习,还能提供可解释的推理过程,解决了传统深度学习模型“黑箱”操作的难题。INN同时具备小样本学习能力,只需少量数据即可提炼规律;支持持续学习新知识,而不遗忘已掌握内容;能同时处理文本、图像、语音等多种信息,支持多模态数据融合处理。广东省智能院多模态脑机接口系统联合实验室主任蔡江解释说,传统AI就像个“黑箱子”,只给答案不说原因,而我们的算法让AI具备了“说理能力”,不仅给出判断,更能解释决策逻辑。

根据现场演示,“智者一号”在单个CPU节点上,只用30小时就完成了百亿token的训练,训练、推理速度可分别达到10万token/秒、50万token/秒,媲美需要多张高端GPU的传统算力集群。同时,它将硬件成本降低了约50%,能耗下降了近90%,噪音接近普通办公室环境。中国科学院院士、广东省智能科学与技术研究院院长张旭表示:“我们长期以来的AI计算,包括大模型训练、推理等等,都依赖于非常大的超算中心,投入很大,耗能也大,对我们老百姓可望不可及。如今,类脑智算体让高性能计算贴近用户成为可能,有望改变完全依赖远程算力中心的局面。”

生态建设方面,“智者一号”拥有完善的专用工具链,非专业人士也能创建功能强大的智能应用。“智者一号”可广泛用于金融、医疗、制造、家庭、教育等垂直领域,比如在家学习老人的健康数据、孩子的学习进度;在办公室适配不同员工的工作习惯,提供个性化的工作流程建议。

其实,类脑计算并不是新鲜事物,比如Intel Hala Point神经拟态计算,就是最知名的类脑算机,配备1152个Intel Loihi 2 CPU,每个都能模拟100万个神经元。还有SpiNNaker 2,无需任何硬盘、GPU芯片,即可运行类脑AI模型,或者存储数据。同时,多家上市科技公司已经布局类脑智能领域,包括科大讯飞、中科曙光、寒武纪、盛视科技、拓尔思、浙大网新等。不过需要注意的是,类脑计算仍处于发展初期,存在架构被颠覆的可能,而且商业化周期较长,从技术验证到规模应用需要3-5年过渡期。

【本文结束】如需转载请务必注明出处:快科技责任编辑:上方文Q文章内容举报]article_adlist-->