高通正式发布AI200和AI250两款AI芯片,标志着其全面进军AI芯片市场。这两款芯片基于高通定制的Hexagon NPU,并针对大语言模型(LLM)和多模态大模型(LMM)进行了优化。相较于竞争对手,高通主打AI机柜解决方案,强调更低的总体拥有成本(TCO)。其突出优势在于支持高达768GB LPDDR内存,并采用创新内存架构,显著降低功耗,提升AI推理的效率与性能。AI250相比AI200拥有10倍的内存带宽,推理速度更快。两款芯片均采用DLC液冷散热技术,并配备160KW机柜级电源。AI200计划于2026年商用,AI250于2027年推出,后续还将有第三款AI芯片。AI初创公司Humain已确认成为首批客户之一,并计划在沙特阿拉伯部署基于高通解决方案的AI基础设施。

🚀 **高通正式进军AI芯片市场**:高通发布了AI200和AI250两款AI芯片,这是其在竞争激烈的AI芯片领域的重要战略布局。这些芯片基于高通在移动和PC领域积累的Hexagon NPU技术,并针对当前热门的大语言模型(LLM)和多模态大模型(LMM)进行了专门优化,旨在提供更高效、更具成本效益的AI算力解决方案。

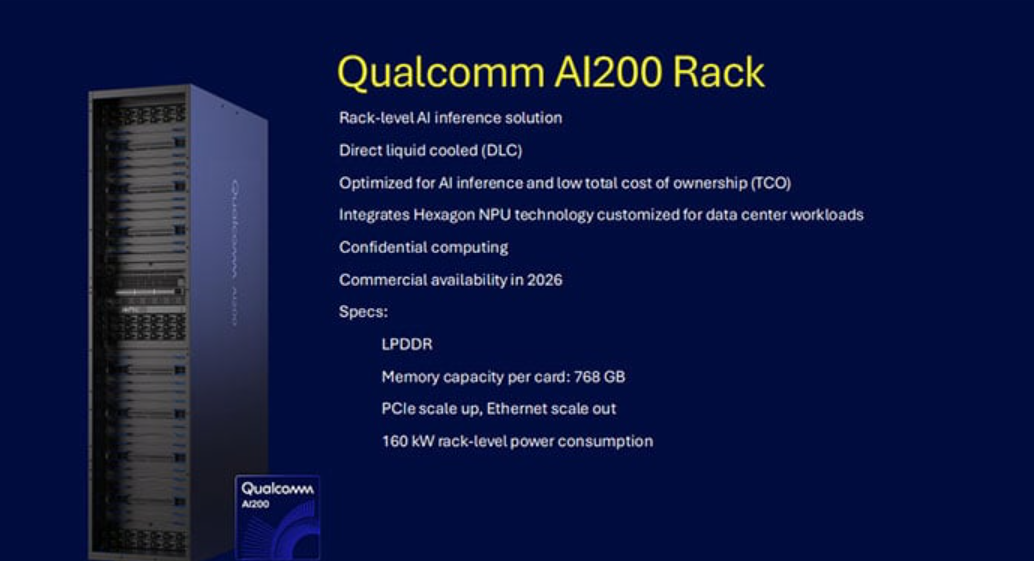

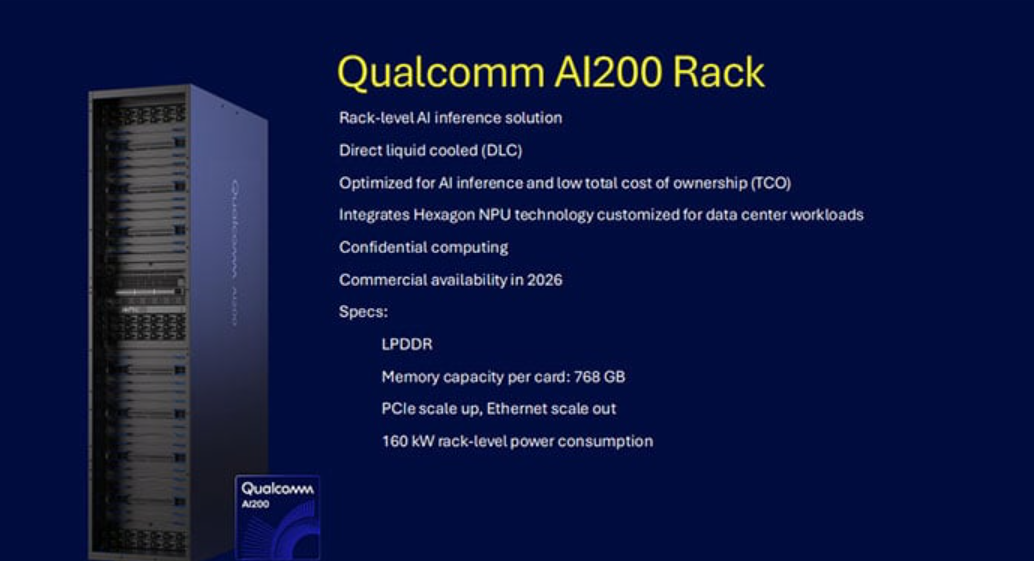

💡 **AI机柜与TCO优势**:高通此次推出的并非单一芯片,而是聚焦于AI机柜整体解决方案。其核心卖点在于提供更低的总体拥有成本(TCO),通过优化的硬件设计和散热方案,力求在长期运营中为客户节省开支。这种打包式的解决方案旨在简化客户部署AI基础设施的流程。

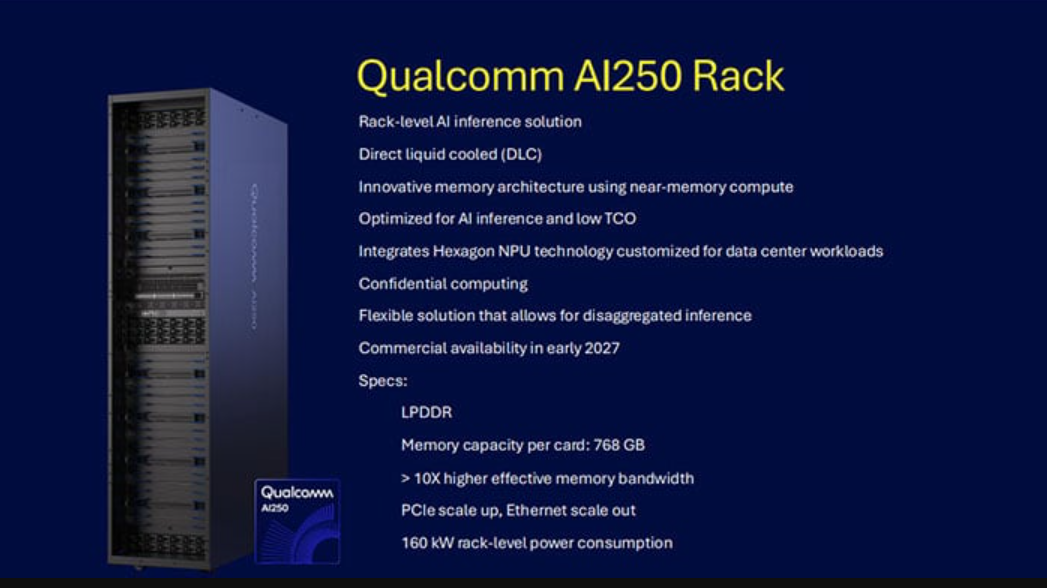

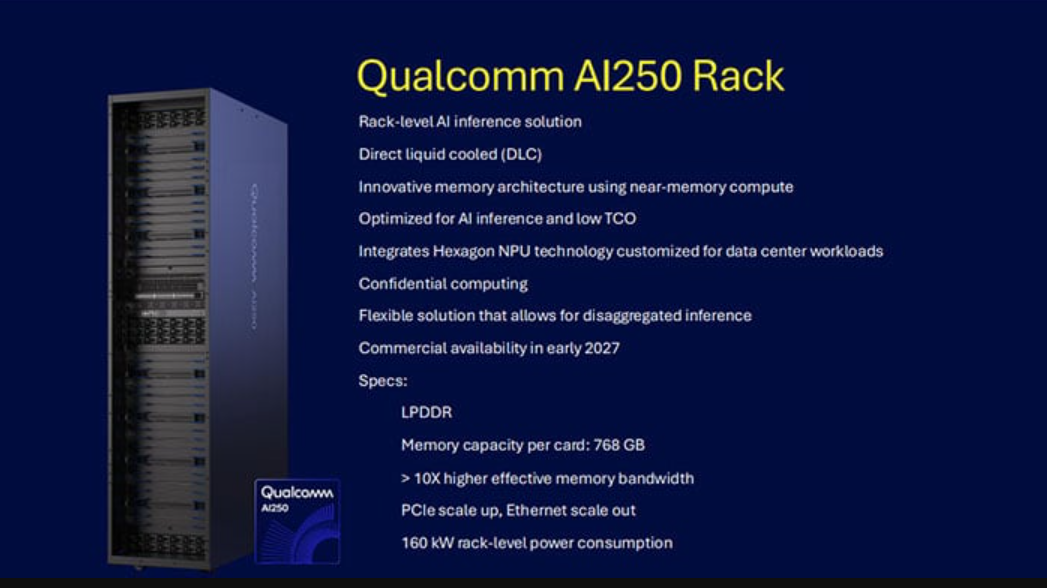

⚡ **内存与能效的飞跃**:AI200和AI250的一大亮点是其超大的内存支持能力,单卡可达768GB LPDDR内存,并引入了创新的内存架构。这不仅为处理大型AI模型提供了充足的内存空间,更通过低功耗设计,大幅提升了AI推理工作的效率和性能表现。AI250更是通过10倍的内存带宽提升,进一步加速了推理速度。

❄️ **先进散热与长远规划**:为了应对AI芯片的高功耗挑战,高通为AI200和AI250配备了先进的DLC液冷散热技术,并采用了160KW的机柜级电源方案,确保了系统的稳定运行。公司还公布了产品发布时间表,AI200将于2026年商用,AI250于2027年推出,并计划在2028年发布第三款AI芯片,显示出其在AI芯片领域的长期投入和发展规划。

🤝 **重要客户率先支持**:高通的新产品发布迅速获得了市场关注,AI初创公司Humain已确认成为首批用户之一。Humain计划在沙特阿拉伯部署一个200兆瓦的AI基础设施,并选择高通的AI机架解决方案,这标志着高通的AI芯片产品得到了早期市场的认可和实际应用场景的验证。

AI芯片的超高利润已经成为各大半导体公司绕不过去的目标,不仅NVIDIA和AMD在抢市场,高通今天也正式杀入AI芯片市场,推出了AI200及AI250两款产品。受此消息影响,高通股价一度飙升20%,达到200美元以上,不过发稿时已经回落到13%涨幅,目前190美元左右。

高通的AI芯片源于定制的Hexagon NPU,应该是高通在手机及PC芯片中使用的NPU单元基础上提升而来的,但高通没有给出具体的性能数据。

高通提供的也不是单一的AI芯片,而是AI机柜,主打一个TCO拥有成本更低的优势,并且对LLM大模型及LMM多模态大模型做了优化。

AI200及AI250的另一个优势就是超大内存,每张卡可支持768GB LPDDR内存,并且引入了创新的内存架构,功耗更低,为AI推理工作负载带来了效率及性能的飞跃提升。

两款产品的主要区别是AI250可提供10倍的内存带宽,这意味着推理速度肯定会更快一些。

散热方面,这两款产品都将使用DLC液冷散热技术,配备160KW机柜级电源方案。

AI200将于2026年商用,AI250则会在2027年推出,2028年还有第三款AI芯片,但具体信息还没公布。

高通新产品发布就获得了重要客户支持,AI 初创公司Humain已确认将成为首批客户之一,该公司计划在沙特阿拉伯部署一个200兆瓦的AI基础设施,配备AI机架解决方案。

查看评论