EXO实验室展示了其最新AI协同网络技术,将NVIDIA DGX Spark与苹果M3 Ultra Mac Studio相结合,大幅提升AI性能。该技术核心是EXO项目,能够智能分配大型语言模型(LLM)的推理任务至用户拥有的各类设备,包括桌面、笔记本、服务器乃至智能手机。最新演示中,DGX Spark的强大计算能力与Mac Studio的超宽内存位宽和快速数据传输能力协同工作,通过EXO 1.0版本形成单一推理管道,效果显著。在Meta Llama-3.1 8B模型基准测试中,此混合设置比单独使用Mac Studio快2.8倍,预示着更大模型和更长提示下性能提升潜力。

🚀 **AI协同网络构建**:EXO实验室成功整合了两台NVIDIA DGX Spark迷你超算与一台苹果M3 Ultra Mac Studio,构建了一个高效的AI协同网络,显著提升了AI的推理性能。

💡 **智能任务分配**:EXO项目是该技术的核心,它能够智能地将大型语言模型(LLM)的推理任务分配到用户拥有的各种硬件设备上,打破了传统上对单一GPU或加速器的依赖,实现了分布式AI计算。

📊 **硬件优势互补**:该协同网络充分利用了不同硬件的独特优势。NVIDIA DGX Spark提供了强大的计算能力,而苹果Mac Studio则以其超宽内存位宽和快速的数据传输能力著称,两者结合形成了一个高效的推理管道。

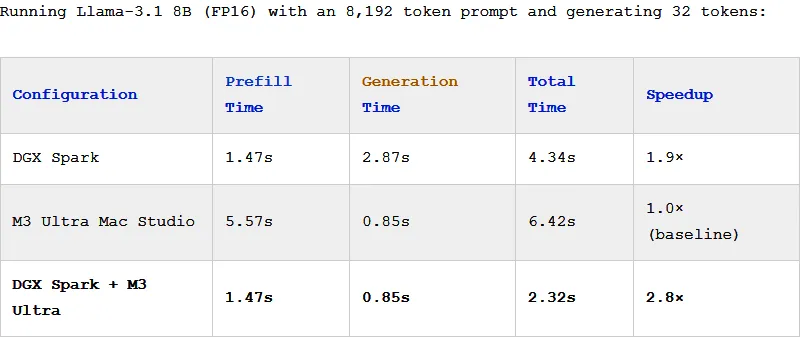

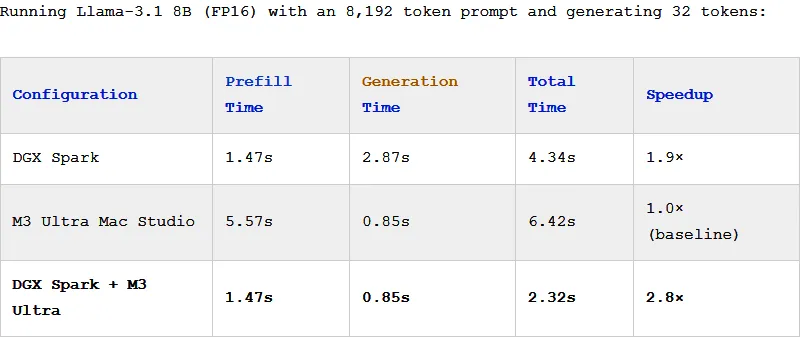

📈 **性能大幅提升**:在Meta Llama-3.1 8B模型的基准测试中,这种混合硬件设置比单独使用Mac Studio的速度快了2.8倍。随着模型规模和处理任务复杂度的增加,性能提升的空间预计将更加可观。

最近,EXO实验室展示了其最新成果:将两台NVIDIA的DGX Spark迷你超算与苹果的M3 Ultra Mac Studio相结合,成功打造出一个高效的AI协同网络,实现了AI性能的大幅提升。

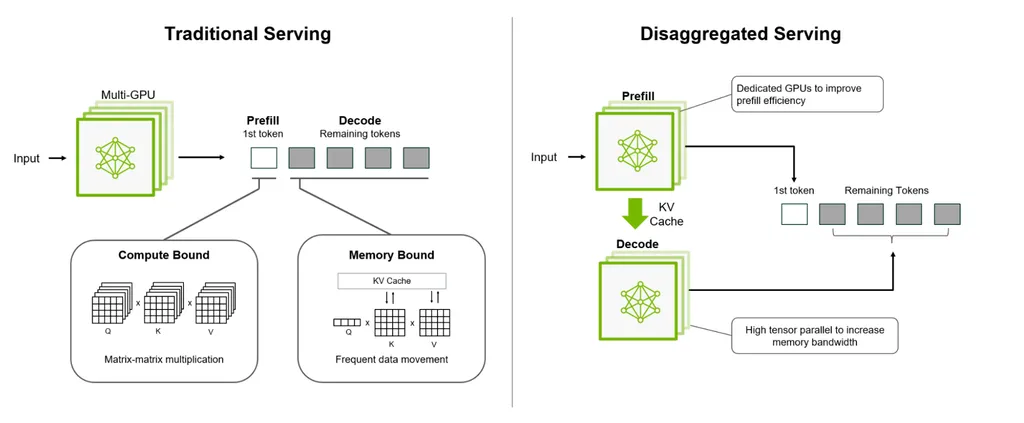

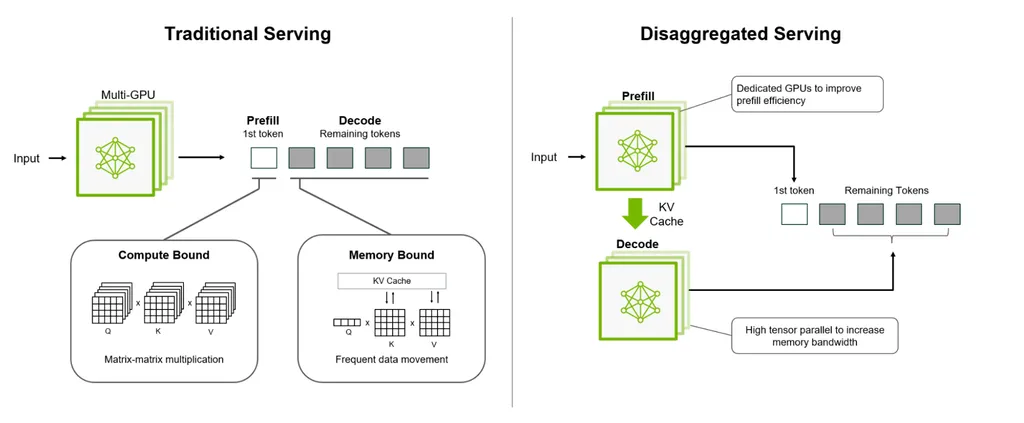

这得益于EXO实验室的主要项目EXO,其核心在于其能够将大型语言模型(LLM)的推理任务智能分配到不同的硬件设备上。

传统上,推理任务通常依赖于单一的GPU或加速器,而EXO则能够自动将工作负载分散到用户所拥有的各种设备上,无论是桌面电脑、笔记本、工作站、服务器、平板电脑甚至智能手机,都可以成为这个协同AI网络的一部分。

在EXO的最新演示中,两台NVIDIA DGX Spark与苹果的Mac Studio被组合在一起,以充分利用了每台机器的独特优势。

DGX Spark拥有强大的计算能力,而Mac Studio则拥有超宽的内存位宽和快速的数据传输能力著称,EXO 1.0版本将这两者融合为一个单一的推理管道,并且效果出奇地好。

在EXO使用Meta的Llama-3.1 8B模型进行的基准测试中,这种混合设置比单独使用Mac Studio的速度快了2.8倍。

这还是在使用相对较小的8B模型和8K-token的情况下,如果使用更长的提示或更大的模型,性能提升可能会更加显著。