1300000000000000!1.3千万亿,一个令人咂舌的数字。这就是Google每月处理的Tokens用量。据Google“宣传委员”Logan Kilpatrick透露,这一数据来自谷歌对旗下各平台的内部统计。

假如参考DeepSeek API文档中给出的标准:

1 个英文字符 ≈ 0.3 个 Token

1 个中文字符 ≈ 0.6 个 Token

那么在中文世界里,1.3千万亿Tokens约2.17千万亿汉字。换算成对话量,一本《红楼梦》的字数在70-80万左右,相当于一个月内所有人和GoogleAI聊了近30亿本《红楼梦》的内容。

更可怕的是,假如按照Google最近几个月的增速来看,这个数字再往下恐怕……

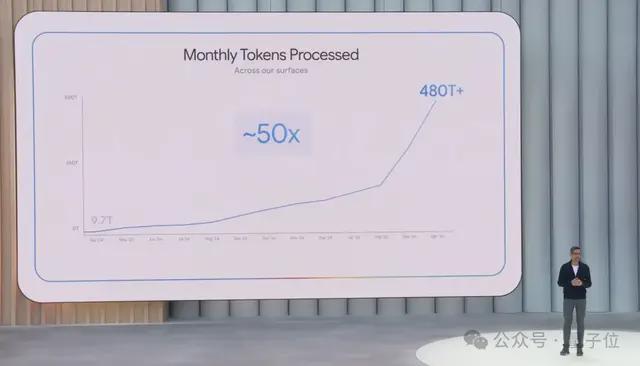

5月份,月均处理480万亿个;

7月份,月均处理980万亿个;

10月份,月均处理1.3千万亿个。

而且需要注意的是,不止Google看重“Tokens消耗量”这一指标,OpenAI最近也首次公布了30家Tokens消耗破万亿的“大金主”。

所以,为什么这个指标重要?它背后又意味着什么?

咱们接着看——

今年已连续暴涨,扛起千万亿大旗

以Google为例,它在这个指标上取得的最新成绩无疑是GoogleAI实力的具象化体现。

根据GoogleCEO皮猜在今年I/O大会上公布的一张图,一年前Google月均处理的Tokens数量才9.7万亿,如今却已突破千万亿级大关。

并且,从大会结束到现在,根据Logan Kilpatrick(真实身份为GoogleAI Studio负责人)提供的内部数据,Google每月处理的Tokens用量还在连续暴涨,且暂未看到任何放缓迹象。

单看Google可能没感觉,那横向对比来看看呢?

根据艾伦AI研究所研究员Nathan Lambert撰写的一篇博客,目前国内外主要大厂的Tokens用量如下:

先说微软。根据微软今年公布的三季度财报,CEO纳德拉曾表示:

本季度我们处理了超过100万亿个Tokens,同比增长5倍,其中仅上个月就创下了50万亿个Tokens的记录。

据此分析,微软的Tokens处理能力还远够不上千万亿级别。而且你别忘了,微软早期就与OpenAI有过合作(负责托管OpenAI模型),起步比Google更早。

而现在,Google却在这一指标上将微软甩在了身后。

此外,像OpenAI、国内的字节跳动、百度等公司,文章指出目前这些公司均达到了日均万亿Tokens的处理量级。

不过这里要插一句,在刚刚过去的开发者日上,OpenAI公布其API调用量为每分钟60亿Tokens,这串数字换算成月度总量是260万亿Tokens。

当然这还只是API的部分,如果加上Tokens消耗量更大的ChatGPT订阅业务,这一数字还会更大,但具体是多少目前则缺少官方数据。

整体而言,仅按公开可查的确切数据来看,Google在“千万亿”这一级确实是独一档的存在。

当然,Tokens用量还只是GoogleAI实力的冰山一隅。

几乎同一时间,Google云还公布了一组最新数据,里面除了提到1.3千万亿这个数字,还表示:

超过1300万开发者使用Google模型进行开发;

Gemini模型目前已生成2.3亿个视频和130亿张图像;

使用GoogleAI概览的用户达到20亿;

65%的客户已经在使用Google的AI产品。

Anyway,即使抛开数据不谈,想必大家也对GoogleAI今年的崛起之势感受颇为明显。

别的不说,传说中的Gemini 3应该快了(坊间传闻原计划于10月9日上线,截至发稿前未正式官宣)。

Tokens消耗量已成新的竞争指标

说完Google,最后回到“Tokens消耗量”这个指标本身。

为什么要看Tokens消耗量?

实际上,Token作为单位能衡量的东西很多,包括预训练语料规模、上下文长度、推理长度……甚至是商业价值。

模型预训练用了多少Token语料,代表了它的基础知识储备含量。

模型能够理解多少Token的输入和输出,反映了它的理解能力。

此外,Token还是大模型推理算力的计量单位。比如底层芯片厂商如今都会通过“每秒生成Token的数量”来证明自家产品的硬件能力。甚至如果有的模型参数未公开,也能通过它的Token生成速度来倒推模型规模(在相同硬件上即可推算)。

当然更重要的是,Token也成为大模型API的定价单位。一旦使用平台的Token数量越多,厂商能够获得的商业价值以及行业影响力自然也越多。

值得一提的是,今年年初,行业围绕Tokens消耗量还诞生了一条新的价值红线——不看融资估值独角兽,看10亿Tokens日均消耗。

作为“入门级”检验标准,10亿Tokens日均消耗背后意味着:

第一,它代表大模型应用落地新趋势,企业拥抱大模型红利,要朝着这一数字前进。

第二,它成为大模型应用落地新阶段的门槛,AI业务真正跑通了吗?需求真实存在吗?都可以此为参考系找回答。

第三,日均10亿Tokens消耗也只是大模型落地“入门级水准”,单客户百万亿、千万亿Tokens消耗是更值得期待的星辰大海。

而如今,远超日均10亿Tokens消耗,Google已经为所有玩家树立了新的标杆。

不知道下一个“千万亿玩家”又会是谁呢?