OpenAI本周一在今年開發者大會Dev Day上公布代理人開發工具AgentKit,可協同開發人員更快開發並部署AI代理人,並強化相關的Eval評估工具及微調工具。

AgentKit 是一套完整的工具,可讓開發商及企業開發、部署和優化代理人。OpenAI三月釋出Responses API和Agents SDK,獲得許多開發人員和企業用來建立代理人workflow,以開發深度研究或客服支援應用。AgentKit則是在Responses API基礎上發展而成,旨在提供整合的代理人開發部署工具。

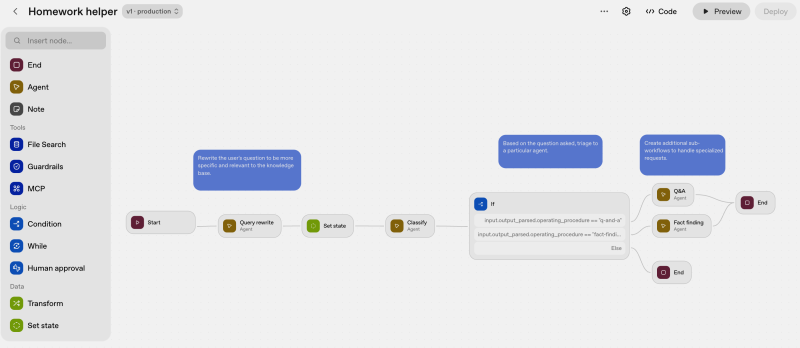

OpenAI表示,過去開發代理人需要開發商自行蒐羅及整合零散的工具,是一沒有版本控管、自訂連接器、手動評估管理、自行調整提示的繁複作業,往往推出前需耗時好幾星期。有了AgentKit,開發人員可以利用其開發構件,以視覺介面設計工作流(workflow),且更快嵌入代理人UI。

AgentKit的構件包括Agent Builder、Connector Registry及ChatKit。其中Agent Builder為建立多代理人workflow及管理版本的視覺化工作區(canvas),使用者利用拖拉節點、連結工具來建立控制邏輯,還能設定自己的護欄。它並支援預覽執行、自訂inline評估、及完整的版本管理。

Connector Registry為管理員管理跨所有OpenAI產品資料和工具連結的中央介面。它能將ChatGPT和API的資料源整合到單一管理介面。其註冊中心(registry)還能透過預建的連接器,讓代理人連第三方系統如Dropbox、Google Drive、SharePoint和Microsoft Teams及MCP伺服器。

ChatKit則能把可客製化聊天代理人嵌入到開發出的應用程式的工具組。OpenAI說,部署代理人聊天 UI其實挺複雜的,需要處理串流的回應、管理對話串,顯示模型思考過程和設計吸引人的聊天體驗。ChatKit則可把這些代理人輕鬆嵌入到開發商或企業自己的App或網站,使其符合主題和公司品牌。

為測試代理人效能,OpenAI也強化了評估工具。去年該公司推出的評估工具Eval提供提示測試和衡量模型行為。本周OpenAI再為Eval加入4項新功能,包括針對資料集,快速從頭打造代理人評估,且可隨時間改進;對代理人workflow執行端到端的評估,並以評分點出缺點。它還會根據人類標註和評分器結果自動優化提示。這個評估工具不只評估OpenAI的模型,也支援第三方模型。

OpenAI還提供強化式微調(reinforcement fine-tuning, RFT),讓開發人員客製化OpenAI的推理模型。現在可在OpenAI o4-mini 上使用,並在GPT-5以private beta提供。OpenAI正和數十家客戶合作改善GPT-5的RFT功能。

目前RFT有二項新功能和改善代理人有關,包括呼叫自訂工具和為評估自訂評分器。

在推出時程上,即日起ChatKit和新版評估(Evals)全面提供給所有開發人員。AgentBuilder目前為Beta版,Connector Registry以Beta版部署到部份API、以及具有Global Admin Console的ChatGPT Enterprise和Edu客戶。

OpenAI計畫很快會將獨立的Workflows API及代理人部署選項加到ChatGPT。