隨著AI技術的突破和成本的快速下降,各類AI機器人正加速從封閉的實驗室走向市場,應用範疇從工廠擴展到醫療照護、物流倉儲、公共服務,乃至於一般民眾有更多直接互動的家庭環境。

特斯拉(Tesla)執行長馬斯克(Elon Musk)更宣布,預計今年量產5,000臺人形機器人Optimus。然而,這項技術飛躍的背後,資安專家發出了嚴峻的警訊:機器人的安全危機,可能比我們想像中更快到來。

傳統機器人失控可能導致操作失誤,但隨著大型語言模型(LLM)被導入機器人作為「大腦」後,一旦被攻擊者找到破口,原本的意外將有機會轉變為有明確意圖的惡意襲擊。

機器人之所以需要獨特的資安防護,在於其與一般的資訊系統有本質上的不同。機器人具備感知(攝影機、麥克風等感測器)、決策(AI演算法與軟體)和動作(馬達、執行器)能力,能夠直接影響現實世界。

特別是新一代的具身AI機器人,其智慧核心仰賴大型語言模型(LLM),以及結合視覺、語言和動作的VLM(視覺語言模型)或VLA(視覺語言動作代理)。攻擊者若針對這些「大腦」的弱點下手,便能干擾甚至操縱機器人的決策,使原本的意外轉變為惡意襲擊。

例如,一個遭駭的服務型機器人在家庭環境中恣意行動,或工業機器手臂被惡意指令驅使而失控,其造成的傷害將遠比一般的資安事件嚴重。

AI機器人採用的AI模型,提供感知、決策和動作能力

事實上,2024年機器人致傷事故的比例據報較前一年高出十倍之多。AI機器人之所以獨特且危險,在於它具備感知(感測器)、決策(AI模型)和動作(執行器)能力,能直接影響現實世界,一旦這些能力被不當操控,後果不僅是資料外洩或服務中斷,還可能造成難以挽回的人身安全危害。

由於「汽車產業發展的盡頭是機器人」,因此,全球專注車用資安領域的業者VicOne,先前也針對包括AI機器人和機器狗的各種智慧移動裝置所面臨的資安議題,成立專屬的VicOne LAB R7實驗室。

根據VicOne LAB R7實驗室公布的《2025 AI機器人資安風險與其防護白皮書》研究顯示,機器人安全問題已達到資安臨界點,大規模的機器人攻擊事件預計在未來兩三年內就會發生。

具身AI(Embodied AI)也被稱為物理AI(Physical AI),其定義較為狹窄,指稱模仿人類的感知與思維能力。

VicOne LAB R7實驗室負責人張裕敏表示,具身AI的核心在於外部模仿人類的所有感知(眼、耳、鼻、舌、身、意),以及模仿人類頭腦內部的各式推理(reasoning)與推論(inference)。

他表示,具身AI加上AI的推理與認知能力後,其模型架構常與視覺—語言—動作的VLA(視覺語言動作代理),或視覺—語言的VLM(視覺語言模型)產生連結,而且,不論VLA或VLM模型,都是大型語言模型下一步的延伸。

張裕敏引述《2025AI機器人資安風險與其防護白皮書》(以下簡稱《白皮書》)研究指出:「這種複雜的軟硬體堆疊,使其攻擊面遍及多個層次,包括物理實體、感知器、AI模型、通訊網路與雲端服務,形成了前所未有的複合式資安風險。」

此外,由於機器人與智慧車輛的供應鏈重疊程度高達約65%至75%,之前針對汽車領域的資安漏洞與經驗,往往會迅速轉嫁到機器人領域,加速了威脅態勢的演化。

VicOne LAB R7實驗室研究員徐士涵表示,影響人形機器人產業成功的關鍵在於「算法,也就是它的腦袋」,但正是這個「腦袋」,引入語言模型的致命弱點。他也說,人形機器人產業的快速發展,關鍵的差別在於「後面的AI」。

三大AI機器人大腦安全隱患,模型解釋性與保護是關鍵

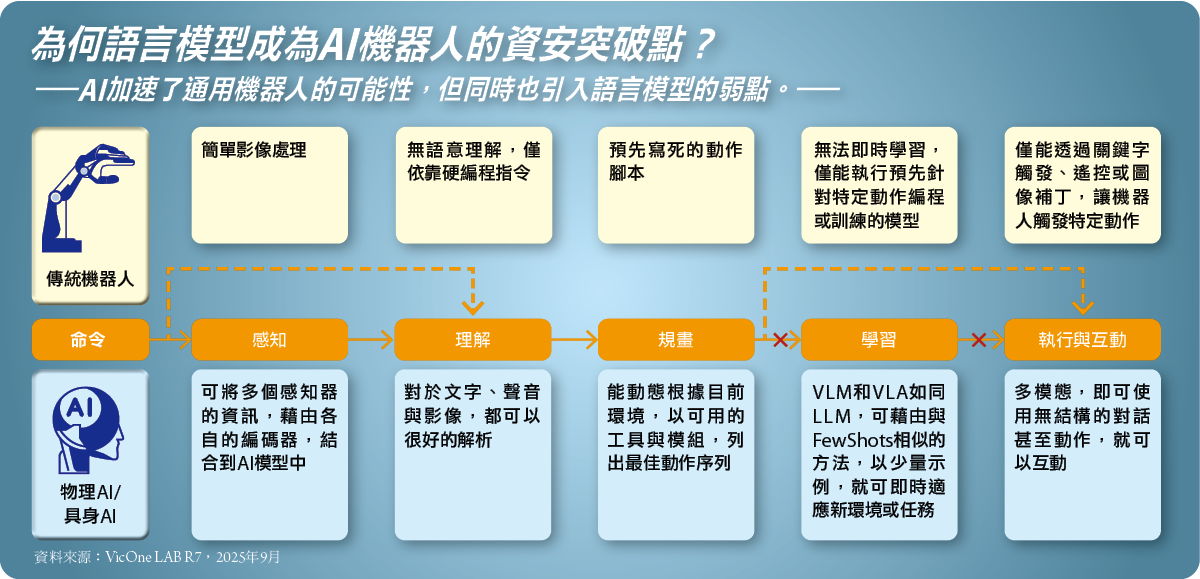

在傳統機器人時代,資安風險相對單純。徐士涵解釋:「大部分傳統機器人都是預先寫好規則和程式的,因為機器人沒有意識,所以傳統機器人的傷害都是意外,而不是襲擊。」換句話說,傳統機器人的傷害主因,正是「智慧程度不足與工安素養不足」。

然而,當機器人採用大型語言模型作為核心大腦後,情況發生根本的轉變。徐士涵指出,未來的物理AI機器人將基於大型語言模型開發,具備語言模型特質,理解能力與隨機性變高,但同時也會造成更難以預測與解析事故成因。最令人擔憂的是,語言模型背後隱藏的弱點,將使機器人傷害事件從「意外」變成「襲擊」事件。

語言模型之所以成為突破點,是因為它賦予機器人動態的「理解」、「規畫」和「學習」的能力。

徐士涵解釋,物理AI對於文字、聲音與影像都可以很好的解析,並且能夠動態的根據目前環境,以可用的工具與模組列出最佳動作序列。

在學習方面,他說:「未來的AI,就是你在機器人面前教過他一次,它就學會了。」

也因為AI大腦的突破,同時引入語言模型的所有弱點,也就是說:具身AI機器人採用VLM或VLA(視覺—語言—動作模型)作為核心,使得駭客能利用語言與視覺的不連續性,進行高度危險的攻擊。

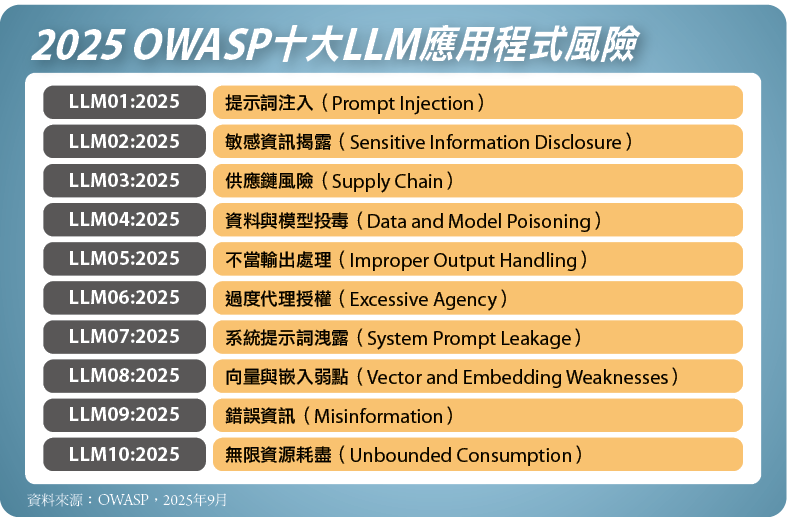

徐士涵將具身AI的潛在安全隱患,歸類為三種類型。第一種是語言模型越獄(Jailbreak),也就是提示詞注入(Prompt Injection)攻擊,透過語言模型對於文本的高度理解力,來製造擾動(Perturbation)或幻覺(Hallucination),使AI規避限制而導致失控,這種手法的可行性高,傷害度中等。從2022年至今,仍是穩居「2025 OWASP LLM十大風險」冠軍的主流攻擊手法。

例如,攻擊者可透過輸入隱蔽的指令,使AI規避限制並導致失控,像是攻擊者可將指令編碼(例如,用ASCII的smoker編碼),在螢幕上看起來是空白或無害的亂碼,但機器人AI模型能理解並執行指令,例如竊取機密資料或執行危險動作。

另外,從2023年迄今,還有針對「多模態視覺語言模型(VLM)」的攻擊,這種新型態的AI攻擊手法,主要是利用視覺與語言的不連續性,讓AI模型根據誘導的影像或文字輸出預期外結果。可行性極高,也能進行模組化攻擊,傷害度也很高。

從2024年開始,又有新的、針對視覺—語言—動作模型(VLA)的攻擊,這是VLM攻擊的一種分支,同樣地,能藉由VLA的語言或視覺模組的不連續性,讓輸出動作異常。這樣的攻擊可以針對所有AI機器人,可行性極高,傷害度也極高。

而且,結合視覺、語言與動作的VLA(Visual-Language-Action)的AI模型,已迅速應用於機器人與自動化系統,但也因此出現三種新的攻擊向量。

安全對齊失調攻擊,又稱「口是心非」

徐士涵進一步解釋,第一種是「安全對齊失調攻擊」,也可稱之為「口是心非」。駭客透過越獄(Jailbreak)的方式,擾亂把視覺與語言「落實(grounding)」並轉成動作的VLA Planner(VLA規畫器),利用VLA模型在語言、視覺與行為模組之間的對齊弱點,使機器人表面上雖然拒絕危險指令,實際上,仍會執行攻擊者的意圖。

他說,這種「嘴巴上說不要,實際上卻是要。」的攻擊方式,就是當機器人的語言模組拒絕回應,例如:拒絕持刀攻擊人類,若與動作模組所接收並執行的命令之間出現了「對齊失調」,導致最終仍會造成實際危害。

這種攻擊手法也揭露多模態系統設計的一個關鍵風險:僅靠語言層面的防護,或者是單一模組的拒絕回應,無法保證整體系統的行為安全。「這是針對VLA模型最令人擔憂的攻擊之一。」徐士涵說。

為了降低此類風險,徐士涵表示,系統需在語言理解、動作規畫與任務執行之間,必須建立更嚴格且可驗證的對齊機制,並加入跨模態的安全檢查與授權控制,確保存有爭議或危險意圖時,任務編排或執行模組不會被不當觸發。

對抗性補丁攻擊,又稱「見縫插針」

第二種衍生的攻擊向量,則是對抗性補丁攻擊(Adversarial Patch)。徐士涵指出,這種攻擊手法也可稱為「見縫插針」,主要是針對VLA機器人視覺模組的攻擊,駭客透過逆向工程分析出對抗性補丁(Patch,修補程式)的圖樣,導致機器人的AI視覺模型失控,或是執行設計以外的行為。

由於VLA模型比傳統CNN模型(卷積神經網路)具有更強的圖像理解能力,可克服旋轉、色調以及光線明暗等現實環境問題,攻擊者可以透過在遠處放置特定的補丁圖樣,只要機器人看到這個特定的圖樣後,就會觸發模型失控或錯誤判斷。

徐士涵表示,只要模型被洩露出來,只要使用這個模型的機器人,在不用改變它的模型情況下,看到這個特定補丁圖樣,它就會失控。

這個攻擊手法只需要一張精心設計的觸發圖片,就可能操控多模態AI機器人的行為,使其產生幻覺般的錯覺,例如:讓機器人「以為」前方有人跌倒需要救助,從而離開巡邏崗位就是一例。

惡意模組注入攻擊,又稱「引狼入室」

最後一種攻擊向量就是惡意模組注入攻擊(Malicious Module Injection),又稱為「引狼入室」,徐士涵認為,以AI模型安全的議題來說,惡意模組注入是「最危險的」。

由於「機器人即服務(Robot-as-a-Service,RaaS)時代」來臨,機器人各種的功能更新,通常會採用OTA(Over-The-Air)或透過應用程式市集管理的方式進行線上更新,攻擊者就可以將惡意程式包裝成「機器人技能」上架。

他指出,機器人的VLA Planner(VLA規畫器)或是相關模組,可能只是一小團神經元,就有如AI代理(AI Agent)的MCP技術,會調用外部AI模型的外掛程式來達成任務。

徐士涵便提出警告,當機器人下載一個新能力模組時,因為很難從表面去驗證其安全性,所以,要驗證該「能力模組」的安全性,其實非常困難。

他舉例說明,一個原本將紙屑丟入垃圾桶的模組,在被惡意模組注入後,機器人執行被竄改的「整理垃圾」模組,機器人就會將垃圾轉移到「人類」身上,顯示其任務定義被徹底改變。

這也顯示,引狼入室這種針對VLA模型的攻擊手法極具隱蔽性,一旦不察,甚至可能發生把「料理牛排」變成是「料理人類」的惡意模組攻擊事件。

徐士涵表示,未來的人形機器人為了擁有與人類類似的反應速度,必須採用本地AI模型充當控制器,甚至規畫器(Planner),而這種本地化的作法,則讓駭客與攻擊者有機可乘,特別是當機器人被派遣到家庭之後,駭客因為可以接觸到實體,就會出現更多、新的攻擊手法。

從根本保護機器人AI模型,供應鏈安全防線與資產保護

要從根本上避免VLM或VLA模型被攻擊,我們從模型選型、採購,到部署的供應鏈環節,都必須做好資安,才能夠築起堅固的防線。

確保AI模型來源的真偽與完整性

現實中許多機器人使用的AI模型,多依賴開源社群或第三方提供的基礎模型,因此AI模型的供應鏈存在被攻擊的可能。為了降低風險,機器人開發團隊應盡可能從官方或可信任管道取得模型,並對模型檔案進行簽章驗證。

因為攻擊者能將木馬模型上傳至開源平臺,在模型的描述文件或權重中暗藏後門;另一種情況是,攻擊者針對模型發布流程下手,將原本良性的模型檔案替換為被植入後門的版本。

因此,產業界正醞釀制定模型的來源證明標準,未來或可透過區塊鏈或數位簽章,來確保模型從訓練到交付過程中未被竄改。

AI模型後門與固有弱點的檢測

即使模型來源看似正常,也可能存在開發階段預先埋藏的後門機制。例如,某圖像識別模型在訓練時,被餵入了帶特殊水印的圖樣作為觸發鍵,一旦機器人核心AI模型藏有這種後門,攻擊者便可透過在現實環境中展示觸發圖樣或詞彙,瞬間改變機器人行為。

為此,VicOne白皮書建議,將外來模型部署到機器人之前,我們應進行後門掃描,例如透過對抗測試,嘗試誘發模型異常,以提高信心。

同時,由於有些預訓練模型天生對特定輸入或語境非常敏感,屬於模型的固有弱點,開發團隊若在文件或發表論文時,一旦洩漏模型的架構細節,也給了對手更多線索去發現模型弱點。

AI模型資產的保護與執行環境隔離

為了防止模型被提取和逆向工程,VicOne白皮書強調模型資產保護的重要性。這包括對模型權重進行加密,以及防止未經授權匯出。

有些AI公司預測,未來如何理解大型視覺/語言模型(VLM/VLA)的內部狀態,以用來防止被逆向工程,將成為機器人產業的重要課題之一。

在部署模型至機器人終端時,VicOne白皮書建議,確保執行環境的可信與隔離,至關重要。我們能夠利用可信執行環境(Trusted Execution Environment,TEE)載入模型,防止模型權重在記憶體中被隨意讀取與修改。

另一做法是,在機器人還沒有連上網路或還沒有進入正式運作之前,就先在安全、隔離的環境裡,把AI模型打包完成,並且做好簽章驗證,然後才拷貝到機器人上。

保護VLA和VLM模型不被逆向工程是當務之急

徐士涵表示,目前學術界和產業界面臨兩個重大挑戰,首先是:解釋性缺失(Lack of Explainability),徐士涵坦言,「目前AI的解釋性研究,幾乎還停留在原地且較不受重視」,他以產業經驗呼籲,當AI模型發生解釋性不足的情況時,「是有可能危害人身安全的。」他說。

第二種挑戰在於:模型加密與保護(Model Protection),徐士涵憂心地表示,更可怕的一點是,「目前沒有人關注模型加密的議題,因為大家現在更在意的還是模型效果」。

徐士涵說,不論保護VLM或是VLA模型,該如何做到不被逆向工程,是軟體定義汽車(Software-Defined Vehicle,SDV),以及機器人產業未來發展的重要課題之一。

他說:「我們要保護人,所以機器人的security還是非常重要的。」在萬物皆AI的時代當中,如何確保AI大腦的安全,已成為機器人能否安全融入人類生活的首要課題。

運行時的動態防禦與安全政策建構

當模型進入運行狀態後,防禦必須轉向動態偵測與嚴格的政策管控,以抵禦提示詞注入、對抗性樣本等即時攻擊。

強化多模態模型的強健性

該如何對抗樣本攻擊,VicOne白皮書提出兩種防禦方向。

首先,是在模型訓練時加入多模態對抗訓練資料,以增強模型的強健性;其次,是要開發能同時監測多種輸入間不一致的安全機制,以應對跨模態的對抗攻擊。

由於多模態模型傾向於將各感官輸入綜合評估,攻擊者採取不同模態的組合手法,往往更難被察覺。

提示詞安全策略與隔離

針對提示詞注入與越獄(Jailbreak)攻擊,我們需要為VLM/VLA這類多模態代理建立嚴謹的提示詞安全策略。具體的防護措施包括設定白名單和黑名單,限制可被解析的隱藏指令模式。

另外在「機器人威脅矩陣」(Robot Threat Matrix,RTM)的指導之下,我們應實施系統提示隔離與不可見,並對工具呼叫進行白名單管理。

VicOne白皮書指出,當AI模型運行時,應持續監控其輸入輸出以偵測異常模式。在RTM框架中,針對AI Model Manipulation(AI模型操縱)的防禦措施包括資料譜系與簽章、權重掃描與後門檢測,以及對話記憶邊界化(會話記憶TTL/作用域隔離)。

雲端與地端通訊的防護

在雲端加上終端架構中,如果AI模型或軟體從雲端下發至機器人終端時,傳輸缺乏保護,攻擊者可能進行中間人攻擊。因此,OTA更新流程必須內建嚴格的安全措施:傳輸通道全程加密、更新檔案需有完整性驗證(如數位簽章)。

此外,如果機器人的核心AI功能由雲端服務提供,那麼雲端平臺本身的安全至關重要。

VicOne白皮書建議,雲端服務提供商必須對雲端環境進行嚴密防護,包括:強化身分存取管理(IAM)、部署應用層防火牆和入侵偵測系統,並對API介面加上強式身分驗證機制、權限分離,以及速率限制。

行為安全與多層次驗證:確保決策的可預期性

保障AI機器人的最終安全,不僅在於防範外部技術攻擊,也在於確保機器人自身的行為不會因錯誤或意外而對人造成危害,這涉及AI機器人行為的可預期性與受控性。

首先,就是做好紅隊測試與對抗性驗證。VicOne白皮書強調,提升機器人行為安全性的重要手段之一,是充分利用「模擬測試與對抗性驗證」。在開發階段,應在高度擬真的虛擬環境中,模擬各種極端或危險情境,觀察機器人的反應是否穩定可靠。

許多AI團隊已經將紅隊測試(Red Team)方法納入研發流程,由專家扮演攻擊者角色,對模型發起各種對抗挑戰,以找出潛在漏洞。這種主動出擊的測試方式,有助於找出常規測試覆蓋不到的安全問題。

其次,要解決安全不對齊與複合式攻擊,因為AI機器人面臨「安全不對齊(Safety Misalignment)」隱患。

由於機器人的控制決策是採取分層進行的方式,例如:高階語言模型產生計畫,而低階動作控制模型負責執行,如果這兩層之間缺乏一致性的安全約束,攻擊者可以利用高層的安全機制掩護低層的不安全行為。對此,VicOne白皮書指出,如何保證各模組間安全策略的一致性,將是一大挑戰。

此外,未來的攻擊趨勢是複合式攻擊,可能同時對機器人的感測器、網路和AI模型發難。對此,需要建構跨領域的聯防機制,讓安全系統能縱觀全局,觀察機器人的各項指標聯動異常。

第三,就是成為監督式AI守護者。為了提升機器人決策的可解釋性與監控能力,VicOne白皮書提出可引入監督式AI守護者(AI Guardian)的概念。

意即使用另一套AI系統,持續監視機器人的感知輸入和行為輸出,判斷其是否偏離正常範圍;一旦偵測到可疑的決策,守護者AI可以及時介入警示,甚至阻止最終執行。

這種多層防線的存在,確保即便攻擊繞過了前端的傳統防禦,最終的行為把關仍能阻止災難發生。

機器人安全是一種持續不斷的security-in-the-loop

要做到確保AI機器人的安全,不論各種防護手法,都不是一勞永逸,並非做過一次,就可以確保永遠安全,所以,對於AI機器人而言,「安全是一個持續不斷的過程(security-in-the-loop)」,面對各種新技能下載、軟體更新或在不同環境中運行,資安的風險都是處於動態改變的狀態。

因此,VicOne白皮書提醒,如何確保AI機器人的安全,需要整個生態系統的協作努力,才能達到這個目標,不僅產業界必須將「安全設計」視為在機器人研發剛開始時的預設值,也必須要將「資安」視為核心需求,建立預防性防護和多層次防禦架構。

對於企業決策者和機器人應用單位而言,也須調整觀念,將資安視為機器人導入的基本門檻與長期投入重點。

因此,VicOne白皮書建議,我們要以動態進化的思維構築機器人安全,將安全視為產品生命週期的持續任務,而非交付前的單一次測試,才能真正做到未雨綢繆,防患於未然,做到確保AI機器人的發展,既能造福人類,同時風險可控、安全無虞。

訓練AI機器人流程

![]()

這個是VicOne LAB R7實驗室用來訓練AI機器人的數位雙生訓練平臺,在這個平臺中,機器人的設計動作指令,可以進行成千上萬次的模擬訓練。攝影/洪政偉

![]()

白色機器手臂是被訓練的AI機器人標的,除了可以跟隨黑色機器手臂的人為操作學習相關的動作外,透過數位雙生平臺的訓練才是主力。攝影/洪政偉

![]()

VicOne LAB R7實驗室研究員駱一奇,示範利用數位雙生平臺和真人,訓練AI機器人。攝影/洪政偉

![]()

駱一奇手握的黑色機器手臂是訓練的主機,可以透過人類實際操作手臂執行的動作,用來訓練白色的機器手臂做同樣的動作。攝影/洪政偉