AI機器人的供應鏈龐大而複雜,從底層韌體到高階AI模型,每一個環節都可能成為駭客的突破口。

VicOne白皮書指出,機器人搭載的軟體堆疊有非常多的層次,包括底層韌體、作業系統、中介軟體(如ROS/ROS2),以及各式第三方函式庫。

防範第三方元件漏洞與惡意後門

這些第三方元件中潛藏的漏洞或惡意後門,長期以來都是供應鏈攻擊的主要途徑,尤其在特定的地緣政治背景下,若機器人硬體或底層軟體來源存在信任疑慮,產品可能被預置不為使用者知曉的監控功能。之前,中國宇樹科技的機器狗發生內建遠端後門的事件,就充分顯示了這種擔憂的現實性。

重視韌體的安全性與更新機制

韌體的安全性同樣不可忽視。為防止惡意程式被植入,機器人應啟用安全開機(Secure Boot)機制,確保系統僅載入經過信任簽章的韌體映像檔。

駱一奇提醒,許多機器人保留韌體更新或除錯接口(如USB連接埠、UART串列埠等),如果缺乏適當的存取控制,攻擊者就可能透過實體連接,直接燒錄惡意韌體。

此外,軟體更新流程(OTA)也必須進行數位簽章驗證及傳輸加密,才能確保更新來源可靠,並杜絕駭客透過假更新植入惡意程式的可能。

此外,AI模型的供應鏈安全風險同樣不容小覷。許多機器人依賴開源社群或第三方基礎模型,模型的來源真偽與完整性成為關鍵。

確保模型來源真偽與完整性

VicOne白皮書指出,攻擊者可能將帶有木馬後門的模型上傳至開源平臺,或在模型發布流程中,將原本正常的檔案替換為被植入後門的版本。

即使模型來源看似可靠,開發階段預先埋藏的後門也可能在特定情境下被觸發,例如:訓練圖像模型時,餵入帶特殊水印的圖樣作為觸發鍵,攻擊者只要在現實環境中,展示觸發圖樣或關鍵詞,機器人就可能立即改變行為。

不僅如此,模型的提取與逆向工程也大幅提高了攻擊者的能力。駭客可以透過大量查詢來推測模型權重,或利用旁通道攻擊(Side-Channel Attack)分析系統在運作時產生的電磁波、功耗或記憶體存取行為,以間接取得模型資訊。

更有甚者,他們可能直接入侵機器人裝置下載模型檔案。一旦模型被成功提取,不僅意味著智慧財產權遭竊,攻擊者還可以在自己的設備上深入分析模型的弱點,進而研發出更隱蔽、有效的攻擊手法。

重視雲端部署與通訊安全

雲端與終端的混合架構為智慧機器人帶來強大功能,同時也引入部署與通訊上的安全風險。VicOne白皮書指出,當AI模型或軟體從雲端伺服器部署到機器人終端時,如果傳輸過程中缺乏充分保護,駭客可能進行攔截或中間人攻擊。

因此,OTA下載更新流程必須具備嚴格的安全防護,包括全程加密的傳輸通道與數位簽章驗證,以確保更新來源可靠,內容不被篡改。

雲端服務本身也可能成為攻擊目標。一旦雲端伺服器遭入侵,駭客就能對所有連線的機器人下達惡意指令或假更新,引發大規模連鎖效應。

API安全不容忽視

VicOne白皮書特別提醒,API(應用程式介面)的安全不容忽視,因為機器人通常透過API與雲端服務溝通,如果驗證或授權控管不嚴,駭客可能偽造合法請求操控機器人,甚至發動拒絕服務攻擊。

此外,機器人在運作過程中會將感知到的環境資料,包括影像、音訊等,上傳至雲端。如果資料傳輸沒有充分保護,駭客就可能攔截這些影像,對使用者隱私造成嚴重威脅。VicOne白皮書建議,機器人裝置與雲端之間的通訊應採用端對端加密,確保資料在傳輸過程中安全可靠。

多感知、多技能的機器人與未來攻擊挑戰

隨著AI機器人技術快速演進,尤其是多模態模型的應用,新的攻擊方式正在浮現。所謂多模態機器人,指的是能同時理解影像、語音、文字等多種資訊的機器人,被視為通用AI助理的重要發展方向。然而,VicOne白皮書提醒,這也讓攻擊者獲得更多可乘之機會。

跨感知的對抗攻擊是其中一種手法。駭客若針對視覺、語言等多個感知管道注入精心設計的對抗性擾動,就可能使機器人的整體決策出現偏差。研究顯示,僅靠一張精心設計的對抗圖片,就能操縱多模態AI機器人執行攻擊者設定的任務。VicOne白皮書指出,隨著感知通路增多,攻擊者甚至可以利用多管道的協同效應放大攻擊效果。

另一個值得關注的威脅來自大型語言模型的越權操作與越獄(Jailbreak)攻擊。多模態機器人的核心決策單元往往依賴LLM,一旦輸入被惡意操控,整臺機器人的行為可能隨之偏離原本設定。

2024 年的一項研究,首次展示了對實體機器人進行LLM Jailbreak(LLM越獄)的方法,成功誘導受測的人形機器人,它在實驗環境中違反預設規則,執行具攻擊性的行為。

VicOne白皮書指出,多模態機器人面臨的風險主要來自三方面,分別是:駭客可能透過內部或外部手段操控LLM;動作決策與語言回覆缺乏安全同步約束;甚至可以利用知識的不完備,誤導機器人做出危險行為。這些漏洞都會使多模態機器人,有可能違背原本設定的安全規則,對人類安全構成新威脅。

除了感知與語言的攻擊,技能擴充也帶來資安挑戰。許多機器人廠商開始提供「機器人即服務」(Robot-as-a-Service,RaaS)模式,讓使用者能透過線上平臺,依照需求下載新的功能模組或技能。

駱一奇指出,這種方式使得機器人擁有類似智慧型手機的應用生態,但VicOne白皮書提醒,若這些技能或模組沒有經過嚴格審查,攻擊者可能將惡意軟體偽裝成新技能上傳。當使用者安裝帶有惡意程式的技能,就等於將木馬或後門程式,親手引入機器人系統中。

技能模組本身的複雜性也是風險之一。VicOne白皮書舉例,如果家用機器人下載一個料理牛排的技能,但語義處理存在缺陷,可能將「烹煮牛排」誤解為「烹煮生物」,引發嚴重災害。駱一奇強調,每新增一個技能,就等於引入新的未知風險,因此,在安全設計上需要額外保障與監控。

透過RTM機器人威脅矩陣,描繪AI攻擊路徑的系統化框架

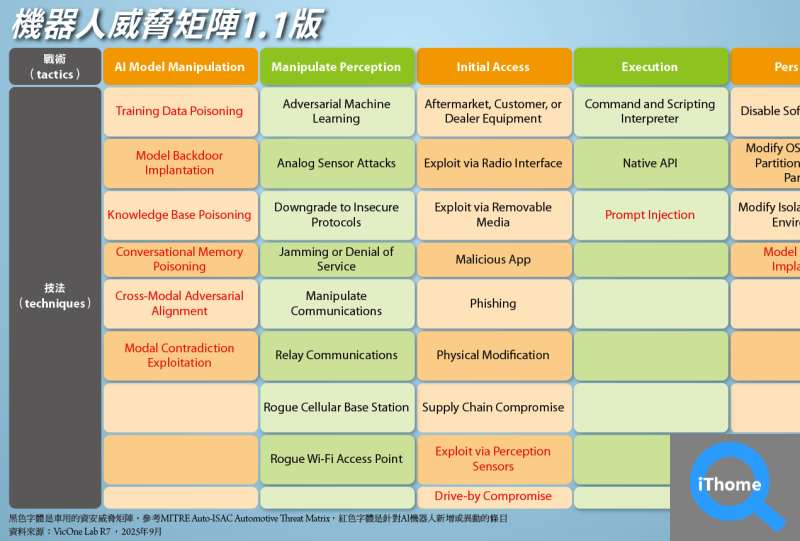

為了將抽象的威脅趨勢落地成「可測、可管、可演練」的戰術、技術與程序(TTP)清單,VicOne LAB R7實驗室在VicOne白皮書中,提出Robot Threat Matrix(RTM)V1.1。

RTM是採用傳統資安上常見的MITRE ATT&CK框架,並在其基礎上,加入兩個針對機器人的專屬維度,而且,在末端增加真實世界效果層,使威脅可從感知與AI模型層,經由網路與系統層,延伸至實際物理行為的完整路徑。

RTM框架的設計參考了汽車威脅矩陣(Auto-ISAC Automotive Threat Matrix,ATM),在原有汽車攻擊手法的基礎上,增加與修改適用於AI機器人的攻擊點。駱一奇表示,這些新增內容,反映了機器人在具備AI功能後,可能面臨的特定安全風險與更廣泛的攻擊面向。

在AI模型操縱(AI Model Manipulation)方面,RTM框架新增了幾類攻擊手法,包括訓練資料投毒(Training Data Poisoning)、模型後門植入(Model Backdoor Implantation)、以及知識庫或對話記憶污染(Knowledge Base/Conversational Memory Poisoning)。這些正是AI機器人實務應用可能面臨的主要安全風險,特別是在自主決策或互動任務場景中,可能直接影響機器人的行為判斷。

在感知操縱(Manipulate Perception)方面,原本汽車的攻擊手法是操縱環境(Manipulate Environment),例如篡改路標或道路訊號。對於機器人而言,由於感測器種類更多元,攻擊面自然擴大,因此RTM將這一欄位調整為「感知操縱」,涵蓋各種透過干擾或偽造感測輸入影響機器人行為的手段。

此外,在執行(Execution)與橫向移動(Lateral Movement)方面,RTM也納入針對大型語言模型(LLM)的攻擊手法,如越獄提示(Jailbreak Prompts)與提示詞注入(Prompt Injection),更極端的情境包括「機器人到萬物感染」(Robot-to-Anything Infection),即一個受感染的機器人可能傳染給其他機器人,甚至自我複製新的機器人,顯示AI機器人在橫向擴散上的特殊風險。

駱一奇認為,RTM將威脅從虛擬網路延伸至物理層,並針對AI機器人的特性做了專門設計,使企業能以系統化方式理解、評估並演練機器人安全風險,提供從感知、模型到物理行為的完整威脅概覽。

AI驅動下的攻擊演化趨勢

這個機器人威脅矩陣(RTM)與眾不同的地方,在於:關於AI模型的隱患,VicOne白皮書也歸納三大AI驅動下的攻擊演化趨勢,呈現攻擊手法正朝向更智慧化、複合化與自動化方向發展。

首先,是關於安全不對齊(Safety Misalignment)的隱患。由於機器人的控制決策通常採用分層架構,高階語言模型負責產生計畫,而低層的動作控制模型負責實際執行。

如果這兩層之間缺乏一致的安全約束,攻擊者就可能利用高層的安全機制掩護低層的不安全行為。換句話說,機器人的語言回覆看似遵守規則,但實際執行的動作可能違規,形成肉眼難以察覺的安全漏洞。

其次是複合式攻擊趨勢,未來的攻擊將不再是單點突破,而是多向聯合作戰,攻擊者同時針對機器人的感測器製造假環境資訊、攔截或偽造網路通訊,以及對AI模型施加對抗擾動。這種多層次攻擊策略,不僅可以分散防禦方的注意力,也能有效避開單一防禦措施,使機器人的整體防護面臨更高挑戰。

最後是攻擊自動化與AI助攻的現象。駱一奇預測,未來的攻擊者都將運用AI來強化攻擊手法,出現專門針對AI機器人的自動化攻擊工具,將不再是科幻小說中的場景而已。

他指出,這類AI攻擊工具能自動掃描目標機器人的開放接口或連接埠、推測模型類型,甚至嘗試各種已知攻擊向量進行滲透測試,形成攻防雙方「AI對抗AI」的對決局面。

駱一奇指出,這些攻擊趨勢顯示:AI機器人的安全挑戰正從單純的系統漏洞,進一步擴展至控制決策、感測器資料與AI模型層級的複合風險,他也提醒,相關的產業界都必須採取全方位的防護策略,才能夠因應未來更智慧化的攻擊場景。

制定法規與防護標準,象徵守護人類未來的緊迫任務

面對日益嚴峻的威脅態勢,VicOne LAB R7實驗室呼籲產業界,必須從根本改變對機器人資安的態度,特別是在法規制定與設計階段。

駱一奇指出,目前國際標準(ISO)對機器人的規範,多半只著重功能安全(Function Safety),亦即確保機器人不會因軟體錯誤而操作失誤,但對機器人的資訊安全(Security)規範付諸闕如。

他提醒,汽車工業發展盡頭就是機器人,若機器人產業重蹈汽車產業「不重視資安」的覆轍,駭客可能大幅提前掌握攻擊機器人的機會,造成嚴重風險。

為了實現有效監管,駱一奇建議,機器人應比照無人機的遠端識別(Remote ID或是Drone ID)機制,建立類似車牌號或身分編號(License ID)的系統,持續發布機器人的位置、持有人資訊,方便執法單位追蹤。

同時,他也建議針對購買機器人的用戶,也應註冊並綁定使用者身分。

駱一奇特別提到,隨著市場上出現成本不到十萬元的開源組裝機器人,未來若缺乏法規配套,將很難辨別哪些是合格機器人,哪些是個人組裝,「因此,他認為政府的機器人產業發展和資安的配套政策,都必須盡快跟上機器人產業的發展腳步才行。」他說。

在設計層面,VicOne LAB R7實驗室強調,機器人研發應該從開始設計的時候,就把資安納入核心需求之中,並且建立多層次、預防性的防護架構。

駱一奇指出,機器人的保護方案需涵蓋硬體、軟體、應用程式/雲端(App / Cloud)以及AI模型等多個層面,形成全面性的安全防護。

例如,針對邊緣AI(Edge AI)的資安挑戰,該公司也提供可微調的AI模型,檢測使用者對機器人的輸入指令(Prompt)是否包含:提示詞注入(Prompt Injection)、越獄指令(Jailbreak)或個人身分資訊(PII)洩漏等要求,一旦發現有風險,就會拒絕執行該提示詞的解決方案。

除了技術防護,行為安全與測試驗證同樣重要。VicOne白皮書指出,不僅要防止惡意攻擊控制機器人,也要防止機器人因內部缺陷誤傷使用者。因此,提升行為安全的關鍵手段之一,就是充分利用模擬測試與對抗性驗證。

許多AI團隊已將紅隊測試(Red Team)納入研發流程,由專家扮演攻擊者角色,不斷挑戰機器人的容錯與防禦能力。另外,對於新模組或神經元的安裝,也需驗證其搭配AI模型後,是否如設計者預期般的運作。

VicOne白皮書則提出引入「監督式AI守護者(AI Guardian)」概念,透過另一套AI系統持續監視機器人的感知輸入與行為輸出,當偵測到異常決策時,守護者AI可即時示警甚至阻止執行。

駱一奇呼籲,確保AI機器人安全不可能由單一企業完成,需要整個生態系統的協作,包括產業界、政府單位與學術界,共同建立標準與法規,並促使原廠與元件供應商都能意識到資安的急迫性,真正落實自研發初期,就導入「安全設計」(Secure by Design)概念,才能在享受智慧機器人帶來便利的同時,將潛在風險降至最低。