Google DeepMind最新升级的AI模型使机器人能够执行更为复杂的任务,甚至可以通过网络获取所需信息。DeepMind机器人部门负责人Carolina Parada在新闻发布会上表示,公司的新AI模型协同运作,使机器人在实际行动前能够“多步推理”,提前规划行动方案。

此次系统升级采用了全新发布的Gemini Robotics 1.5和Gemini Robotics-ER 1.5这两款模型,对今年三月发布的AI模型进行了重大改进。现在,机器人已不再局限于单一的任务,比如折纸或拉开拉链,而是能够处理更复杂的操作,例如按深浅分拣洗衣物、根据伦敦当前天气打包行李,甚至通过针对当地要求进行网络搜索来协助垃圾、堆肥和回收物分类。

Parada介绍:“以往的模型能够很好地执行一条指令,并且具有广泛适用性。这次升级后,我们实现了从接受单一指令到真正理解和解决实际物理任务的转变。”

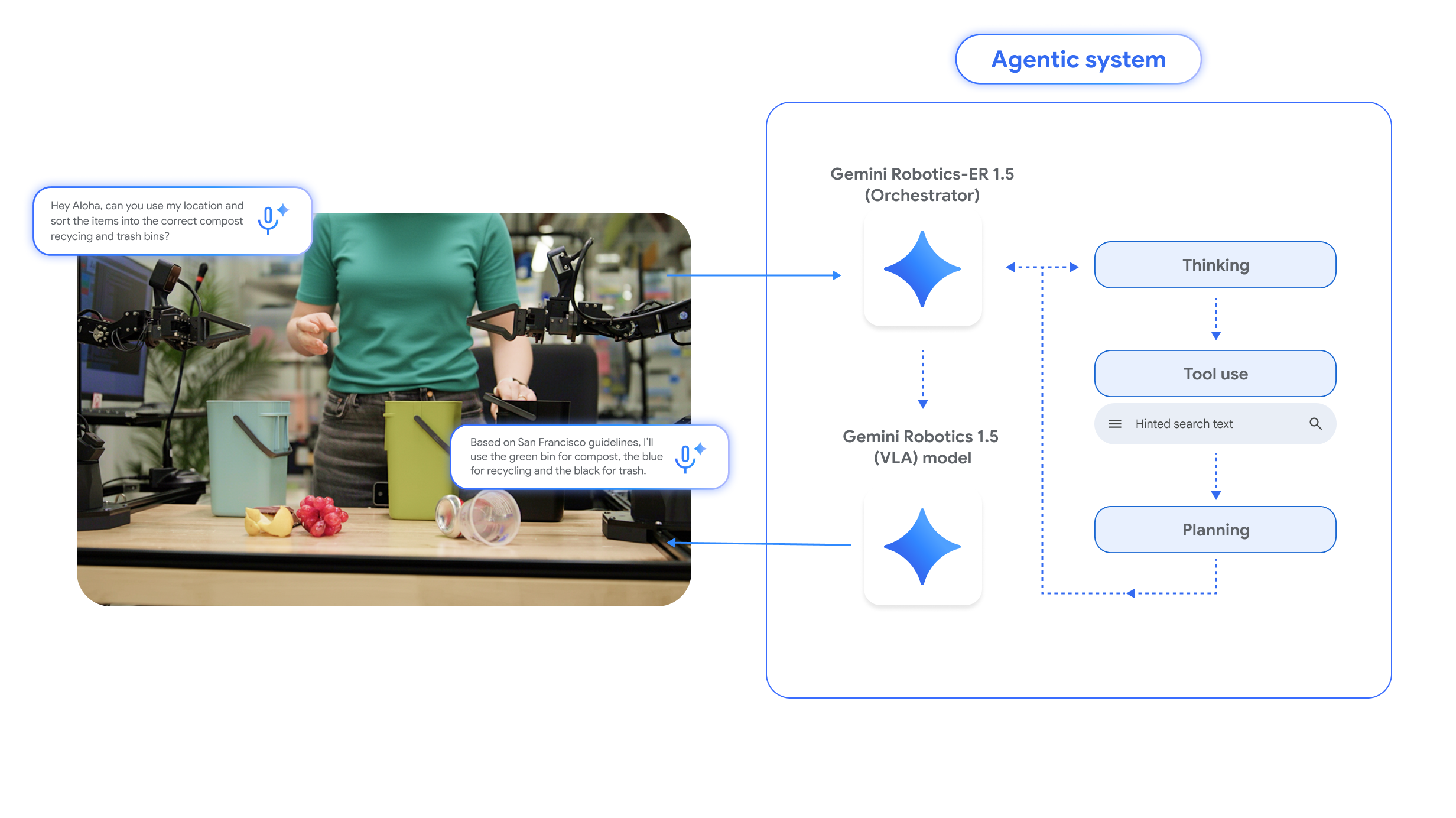

具体而言,机器人首先利用升级后的Gemini Robotics-ER 1.5模型理解其所处环境,并像人类一样使用Google搜索工具查找信息。随后,Gemini Robotics-ER 1.5会将搜索结果转化为自然语言指令,再交给Gemini Robotics 1.5模型,让机器人结合视觉和语言理解能力完成每一步操作。

DeepMind软件工程师Kanishka Rao指出,这些AI模型能够帮助不同构造的机器人互相“学习”,哪怕硬件配置存在差异。实验发现,ALOHA2机器人(配备机械臂)完成的任务可以直接在Franka双臂机器人及Apptronik“阿波罗”类人机器人上复现,“这意味着我们能用一个模型控制各类机器人,包括类人型机器人,且某个机器人习得的技能可以迁移到另一台机器人身上。”

Gemini Robotics-ER 1.5现已通过Gemini API在Google AI Studio向开发者开放,但Gemini Robotics 1.5仅对部分合作伙伴开放体验。

这一突破让机器人具备了利用网络为现实问题寻求解决方案的能力,有望推动自动化应用领域再上新台阶。