导语

继「神经动力学模型」与「计算神经科学」读书会后,集智俱乐部联合来自数学、物理学、生物学、神经科学和计算机的一线研究者共同发起「从神经动力学到意识:跨尺度计算、演化与涌现」读书会,跨越微观、介观与宏观的视角,探索意识与智能的跨尺度计算、演化与涌现。重点探讨物理规律与人工智能如何帮助我们认识神经动力学,以及神经活动跨尺度的计算与演化如何构建微观与宏观、结构与功能之间的桥梁。

【从经典到前沿】重尾连接如何重塑神经网络动力学?是否更接近真实大脑?加入我们的读书会,共同解析重尾RNN的独特魅力与未解之谜!

分享简介

分享简介

传统的RNN模型通常假设神经元之间具有强度服从高斯分布的全连接或者具有相同强度的稀疏连接。然而,实验和理论表明神经元之间的连接强度更接近重尾(heavy-tailed)分布。由于重尾分布的二阶矩通常发散,常规的分析理论如动力学平均场(dynamic mean-field)和扩散近似不再适用。所以,重尾神经网络的动力学与经典的高斯或稀疏均匀神经网络完全不同,将经典 RNN 理论推广到重尾 RNN 对连接理论与实验结果具有重要意义。在这一部分,我们将回顾关于重尾 RNN 动力学的文献,对比高斯网络和重尾网络的动力学,并讨论这些理论结果在神经科学背景下的意义和其他开放问题。

核心关注问题

核心关注问题

重尾连接分布如何塑造神经网络的动力学和信息处理?

重尾网络动力学是否与真实脑网络的动力学更接近?

重尾神经网络在机器学习领域有什么潜在的应用?

分享大纲

分享大纲

高斯随机神经网络

动力学平均场理论 (Dynamic mean-field theory)

Lyapunov 谱

混沌动力学的其他定量描述

遍历性和玻璃相

均匀脉冲神经网络

扩散近似和群体密度方法(population density method)

均匀 LIF 网络的相图

非同步相(asynchronous irregular state)与动态平衡

重尾神经网络

储备池计算(reservoir computing)

回声状态网络(echo state network)

混沌边缘

遍历性与记忆

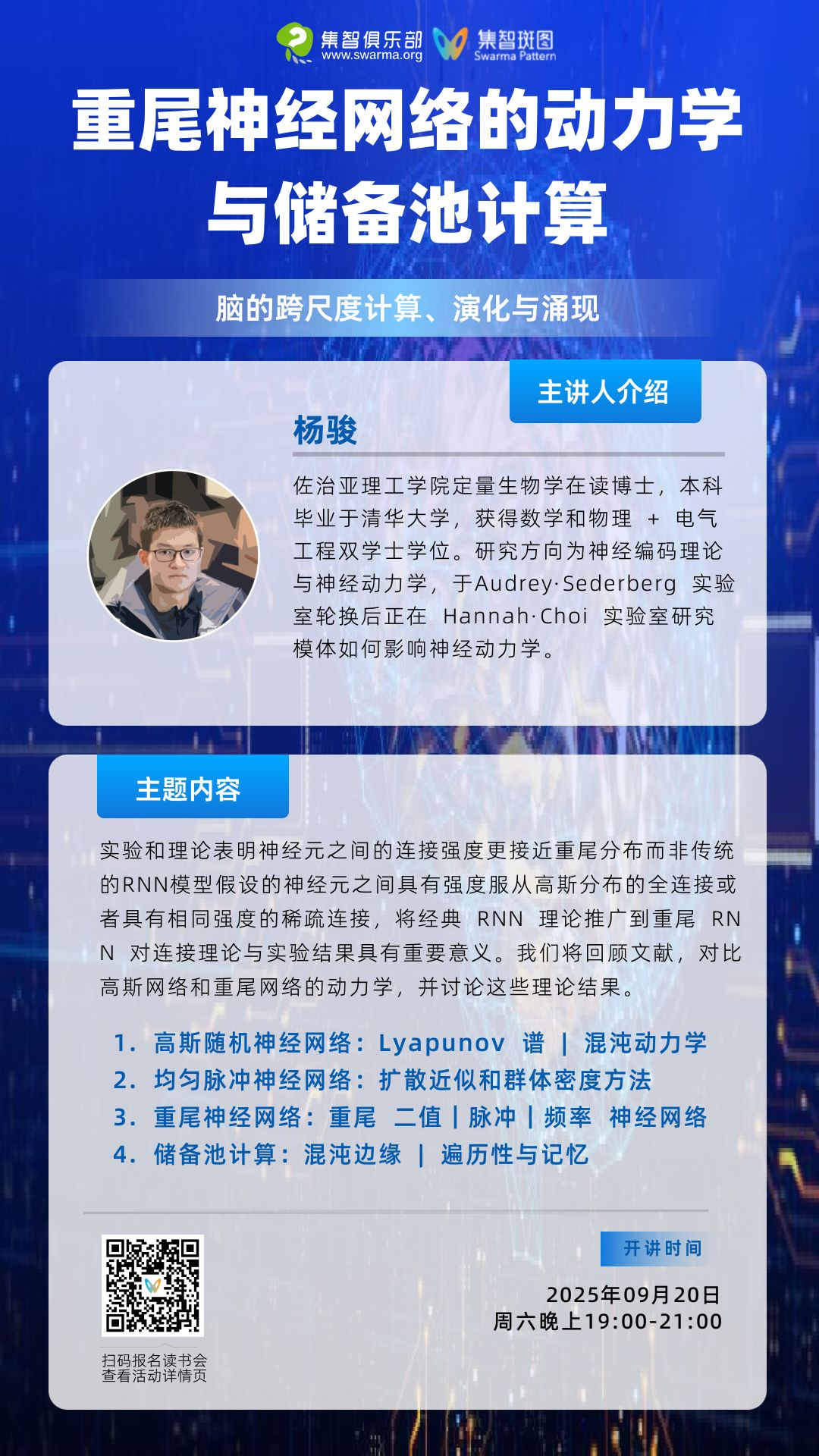

主讲人介绍

主讲人介绍

杨骏,佐治亚理工学院(Georgia Tech)定量生物学在读博士,本科毕业于清华大学,获得了数理基础科学 + 电气工程双学士学位。本科时曾师从 Sukbin Lim 和 Mayank Mehta 研究神经科学。在Audrey Sederberg的实验室完成短暂轮转后,现在正在 Hannah Choi 的实验室探索网络模体(motif)对动力学的影响。研究兴趣:神经编码理论与神经动力学。

参与方式

参与方式

参与时间

2025年9月20日(周六)晚上19:00-21:00(固定时间,记得关注获取每周分享信息~)

报名加入社群交流

https://pattern.swarma.org/study_group_issue/973?from=wechat

扫码参与「从神经动力学到意识:跨尺度计算、演化与涌现」读书会,加入社群,获取系列读书会永久回看权限,与社区的一线科研工作者沟通交流,共同溯源复杂科学的思想脉络。

领域必读文献17篇

领域必读文献17篇

核心解读:

这是第一篇讨论重尾神经网络性质的文献。这篇文章发现 Cauchy 连接 RNN 有类似神经元雪崩的临界行为。

Kuśmierz, Ł., S. Ogawa and T. Toyoizumi (2020). "Edge of Chaos and Avalanches in Neural Networks with Heavy-Tailed Synaptic Weight Distribution." Physical Review Letters125(2): 028101.

第一篇讨论重尾 SNN 的文献。将经典神经网络的 population density method 中的扩散近似推广到重尾神经网络的分数阶扩散近似。

Wardak, A. and P. Gong (2021). "Fractional diffusion theory of balanced heterogeneous neural networks." Physical Review Research3(1): 013083.

研究了一个纯抑制性的 lognormal 网络,并考虑了连接的对称性如何破坏遍历性(lognormal 的二阶矩有限)。

Berlemont, K. and G. Mongillo (2022). "Glassy phase in dynamically-balanced neuronal networks." bioRxiv: 2022.2003.2014.484348.

唯一一篇讨论连续时间重尾神经网络动力学的文章。给出了重尾随机矩阵的谱密度和 Lévy 平均场理论,发现了重尾神经网络动力学的多重分形结构,并讨论了局域化对于储备池计算(reservoir computing)的意义。

lWardak, A. and P. Gong (2022). "Extended Anderson Criticality in Heavy-Tailed Neural Networks." Physical Review Letters129(4): 048103.

推广到有限大的 Lévy α-stable 离散时间 RNN,详细讨论了动力学的维数问题。

Xie, Y., S. Mihalas and Ł. Kuśmierz (2025). "Slow Transition to Low-Dimensional Chaos in Heavy-Tailed Recurrent Neural Networks." arXiv. 将 Kuśmierz et al. (2020)

推荐阅读:

这篇文章使用了包含一种兴奋性神经元和 PV, SST, VIP 三种抑制性神经元的稀疏 lognormal SNN,但没有对该网络的详细动力学分析。

Guo, L. and A. Kumar (2023). "Role of interneuron subtypes in controlling trial-by-trial output variability in the neocortex." Communications Biology 6(1): 874.

发现在具有随距离 lognormal 分布的连接强度的 SNN 中存在一种次序传播。

Riquelme, J. L., M. Hemberger, G. Laurent and J. Gjorgjieva (2023). "Single spikes drive sequential propagation and routing of activity in a cortical network." eLife 12: e79928.

高斯神经网络的经典文献。给出了经典混沌 RNN 的 Lyapunov 谱。

Engelken, R., F. Wolf and L. F. Abbott (2023). "Lyapunov spectra of chaotic recurrent neural networks." Physical Review Research 5(4).

高斯神经网络的经典文献。讨论了连接的一阶和二阶统计量如何影响经典 RNN 的 participation ratio(PR)维数。

Clark, D. G., L. F. Abbott and A. Litwin-Kumar (2023). "Dimension of Activity in Random Neural Networks." Physical Review Letters 131(11): 118401.

联系了高斯 RNN 和稀疏均匀 RNN 的混沌相变,并讨论了 SNN 中的类似现象。

Kadmon, J. and H. Sompolinsky (2015). "Transition to Chaos in Random Neuronal Networks." Physical Review X 5(4).

高斯神经网络经典文献。讨论了混沌相的平衡点分布。

Stubenrauch, J., C. Keup, A. C. Kurth, M. Helias and A. van Meegen (2025). "Fixed point geometry in chaotic neural networks." Physical Review Research 7(2): 023203.

从理论上给出了从协方差分布区分混沌边缘和临界雪崩两种临界动力学的方法。

Dahmen, D., S. Grün, M. Diesmann and M. Helias (2019). "Second type of criticality in the brain uncovers rich multiple-neuron dynamics." Proceedings of the National Academy of Sciences 116(26): 13051-13060.

第一篇讨论 RNN 动力学局域化的文献。

Monteforte, M. and F. Wolf (2010). "Dynamical Entropy Production in Spiking Neuron Networks in the Balanced State." Physical Review Letters 105(26): 268104.

简单的可塑性规则如何产生重尾分布的连接。

Lynn, C., C. Holmes and S. Palmer (2024). "Heavy-tailed neuronal connectivity arises from Hebbian self-organization." Nature Physics 20: 1-8.

处理稀疏均匀 SNN 的经典方法。

Brunel, N. and V. Hakim (2022). Population density model. Encyclopedia of Computational Neuroscience. D. Jaeger and R. Jung, Springer, New York, NY: 2846-2865.

社区招募:

Morrell 模型通过引入若干个缓变隐变量可以产生类似于生物神经网络中观察到的临界雪崩。

Morrell, M. C., I. Nemenman and A. Sederberg (2024). "Neural criticality from effective latent variables." eLife 12: RP89337.

Morrell, M. C., A. J. Sederberg and I. Nemenman (2021). "Latent Dynamical Variables Produce Signatures of Spatiotemporal Criticality in Large Biological Systems." Physical Review Letters 126(11): 118302.

内容中包含的图片若涉及版权问题,请及时与我们联系删除