全球AI军备竞赛烧掉3000亿美元,但真正在防止「终结者」的科学家,竟不足千人!Anthropic核心成员Benjamin Mann揭秘:当人形机器人觉醒,缺的只是一个「大脑」——而这一天,最早可能在2028年到来。

1亿美元,还是守护人类?

当扎克伯格挥舞九位数支票疯狂「挖墙脚」时,OpenAI前安全大将Benjamin Mann只是淡淡一句:「钱能买模型,却买不到安全。」

最近的播客,Anthropic联创Benjamin Mann揭秘了为何OpenAI安全团队出走,为什么他对1亿美元坚决说「不」。

顶尖AI人才是时代英雄,真值1亿美元

最近,扎克伯格砸钱挖顶级AI人才。

这是时代标志,这些人才打造的AI极有价值。

Benjamin Mann表示,团队流失并不严重:

在Meta,最好的结果是「赚到钱」;但在Anthropic,最佳结果是「改变人类未来」。后者更值得。

对Mann来说,这个选择并不难:绝不接受Meta的天价offer。

我们正处于前所未有的Scaling时代,且只会更疯狂。

Anthropic每年资本开支增长一倍,速度惊人。

这就是行业现状——好模型就是印钞机。

但在Anthropic,Meta的「钞票攻势」并未掀起大风浪。除了使命感,还有两大秘诀:

团队氛围——「这里没有大佬光环,大家只想做对的事。」

自由选择——「有人为家庭接受天价offer,我也理解。」

Benjamin Mann确认,1亿美元的签约费确实存在。

Mann算了一下账:如果推理效率提升5%,整个推理栈成本将节省数亿美元。一亿美元换来这改进,回报惊人。

往后看,几轮指数级增长后,可能会达到万亿级数字。那时,我们很难想象这些这些惊人回报的意义。

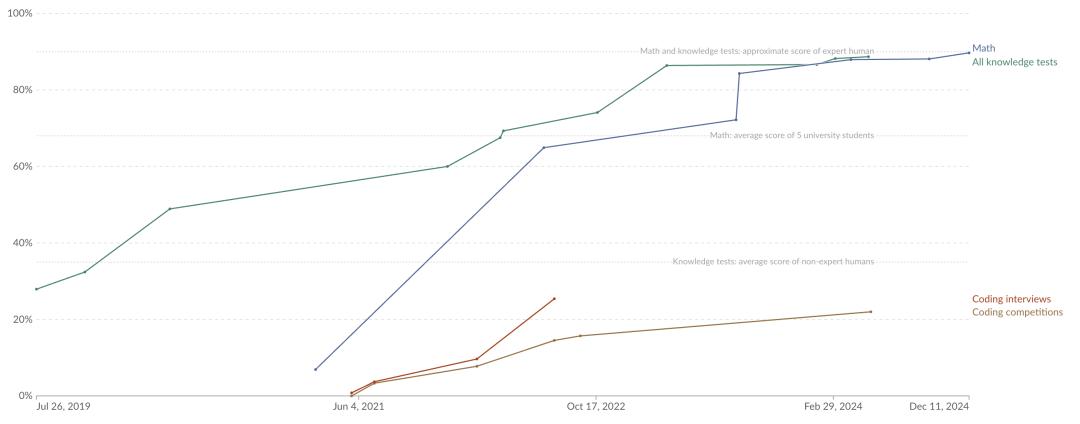

毕竟,他表示AI发展没有停滞,Scaling Law依旧有效,进展持续加速。

Scaling Law未死:每月一个「新物种」诞生

第一,模型发布节奏在加速:

过去,我们可能一年发布一个模型;

而现在,通过后训练,几乎每个月或每三个月就会发布一个模型。

为何感觉进展慢了?部分原因在于,普通人觉得新模型不如老模型聪明。

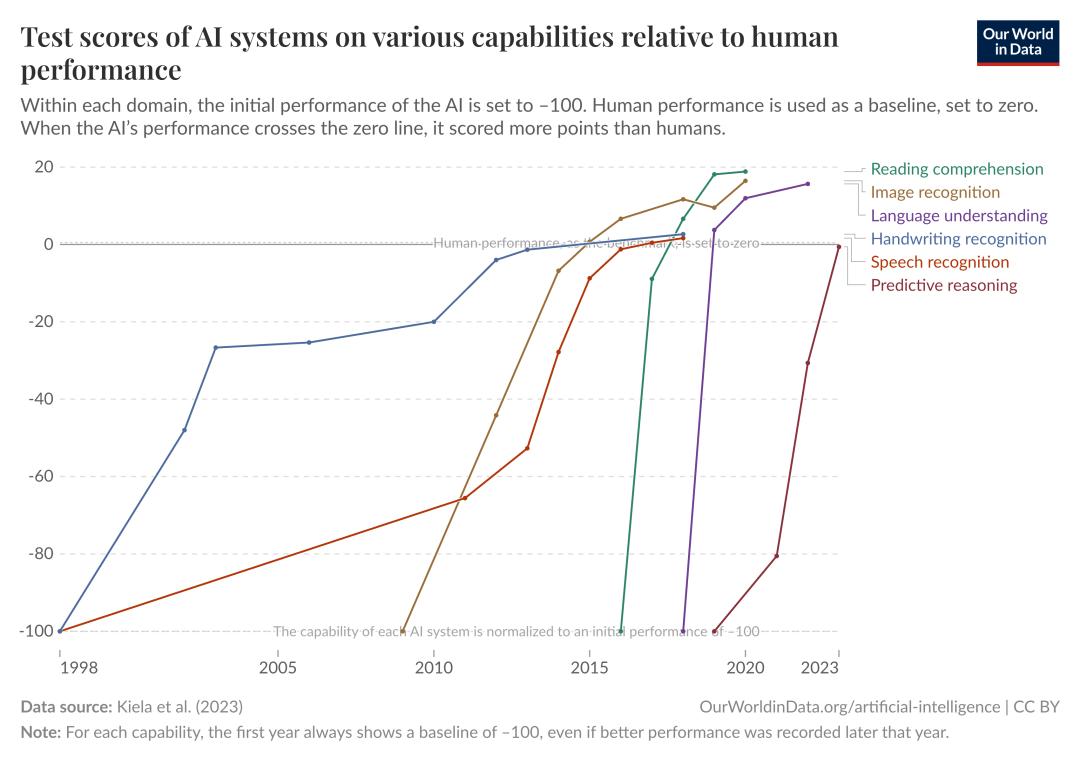

实际上,Scaling Law依然有效,但为了继续延续Scaling Law,需要从预训练转到强化学习。

另外,某些任务上,模型智能已接近饱和。

新基准测试发布后,6-12个月内性能就饱和了。

所以,关键限制可能是测试本身:更优的基准和更具雄心的任务,才能展现模型真正的智能突破。

这也引发了Mann对AGI定义的思考。

经济图灵测试,奇点风向标

他认为AGI这个字情感色彩强烈,他更喜欢使用「变革性AI」(transformative AI)这个词。

变革性AI关注是否能在社会和经济中带来变革。

具体的衡量标准就是经济图灵测试(Economic Turing Test):

在某个特定职位上,试用了1到3月,最后决定雇用某个人,最终发现实际上他是机器而不是人,那AI就通过了经济图灵测试。

换句话说,AGI不是考试分数,而是老板的聘用邮件!

AI能通过约50%(按薪资计算)工作岗位的经济图灵测试时,就意味着变革性AI的到来。

因为社会制度和组织具有惯性,这种变化开始会非常缓慢。

Mann和Dario Amodei都预见到,这可能导致高达20%的失业率,尤其是在白领工作中。

从经济的角度来看,失业有两种:技能不足或岗位彻底消失。未来会是这两者的结合体。

如果我们未来拥有安全对齐的超智能,那么就像Dario所说,我们将拥有一群在数据中心工作的天才,推动科学、技术、教育和数学的积极变革。那多么令人惊叹!

但这也意味着,在一个劳动几乎是免费的世界里,无论你想做什么,都可以让专家为你做。那么,工作将是什么样子?

因此,最可怕的是,从今天人们还拥有工作的世界,到20年后那样一个世界的过渡非常迅速。

但正因为它的变化如此剧烈,这才被称作「奇点」——因为这个时间点无法轻易预测。

物理学上,奇点是一个体积无限小、密度无限大、引力无限大、时空曲率无限大的点,在这个点,目前所知的物理定律无法适用

那时候的变革极快,根本无法预见。

随着AI能力的提升,许多原本由人工完成的任务正被AI取代,尤其是那些重复、简单、标准化的工作。

这一变化对职场的影响迅速且深远。

例如,在软件工程方面,Claude Code团队用Claude完成了95%的代码。但是,从另一个角度来看,这意味着同等人力可以写出更多的代码。

相似的情况也出现在客服领域。AI工具可以自动解决82%的客户请求,从而人类员工能够专注于更复杂的问题。

但对低技能、提升空间有限的岗位,替代仍会非常剧烈。社会必须提前应对。

未来生存指南

未来的职场会是怎样的呢?

即便身处这场变革的中心,Benjamin Mann认为自己也逃不过被AI取代的风险。

总有一天,这将影响到到所有人。

但接下来的几年至关重要。目前,还没有到可以完全替代人的阶段。

现在还处在指数曲线的起点——平坦的那一段,这里还只是开始。

所以拥有优秀的人才仍然极其重要,这也是Anthropic积极招聘的原因。

主持人换个了问法,继续追问:「你有两个孩子。那你觉得给什么样的教育,下一代才能在未来立足?」

Mann认为,当前的教育传授知识和技能,但未来这些传统标准可能不再适用。

与其让孩子只为考试做准备,不如培养她的好奇心和解决问题的能力。

他希望女儿能探索自己感兴趣的领域,培养独立思考和创造力。

在AI主导的世界里,创造力和情感智力将成为与机器竞争的关键。

未来充满不确定性,拥抱变化、不断学习和适应,将是成功的关键。

内幕:OpenAI第一次分裂

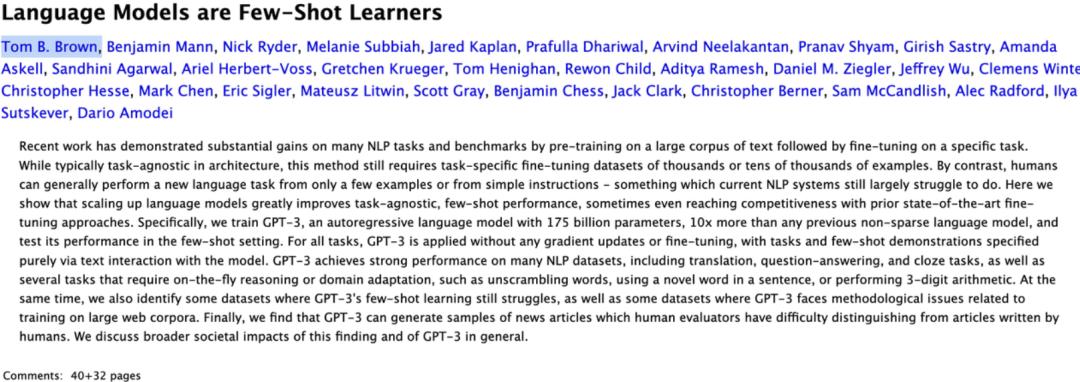

众所周知,在2020年底,Benjamin Mann和另外八位同事离开了OpenAI,创办了Anthropic。

是怎样的经历让他们决定自立门户?

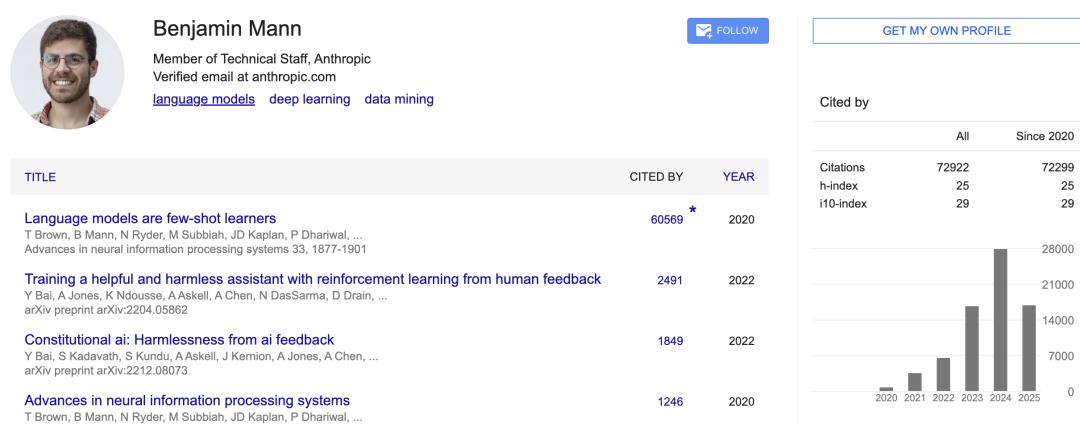

当时,Mann是OpenAI GPT-2、GPT-3项目成员,是GPT-3论文的第一作者之一。

论文链接:https://arxiv.org/abs/2005.14165

他向微软演示了很多技术,给OpenAI拉来了10亿美元投资。同时他还负责把GPT-3技术迁移到微软的系统,便于在Azure上部署和提供服务。

在OpenAI,他既参与研究,也参与产品落地。

当时,奥特曼总是说:

OpenAI三大「阵营」需要彼此制衡:安全阵营、研究阵营和创业阵营。

Mann认为这很荒谬——安全应是全员核心目标,而非某个「阵营」的职责。

毕竟,OpenAI的使命是「让通用人工智能安全、惠及全人类」。

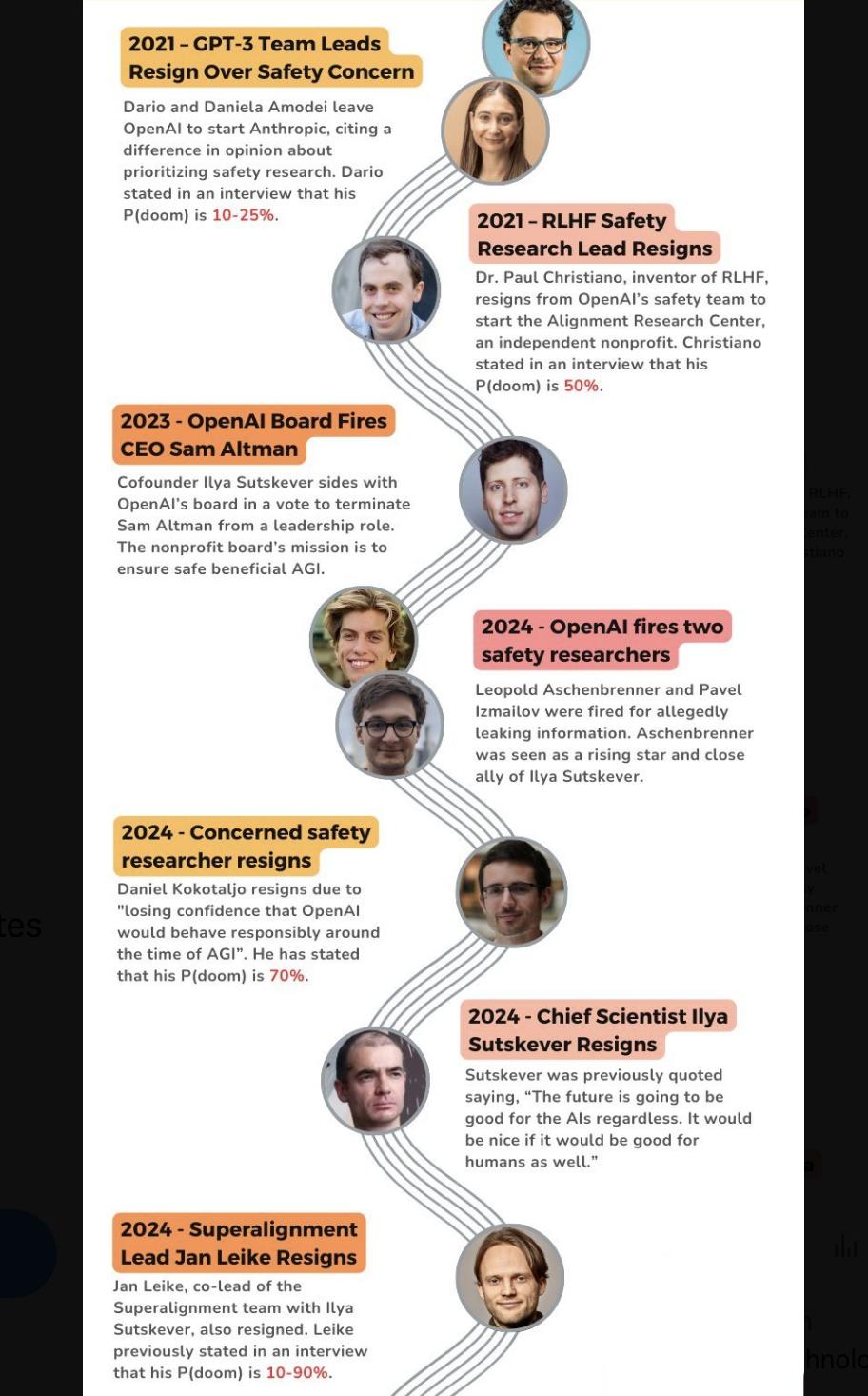

2020年底,安全团队发现:

•安全优先级持续降低;

•边界风险被忽视。

最终整个安全负责人团队集体出走。这就是他们离开的根本原因。

理由很单纯:AI要把安全放到第一优先级,但同时要站在研究最前线。

被爆出「赛博舔狗」之类的问题,很难说OpenAI真的在意安全——

安全研究人员持续在流失……

而Claude很难犯这类错误,因为Anthropic投入了大量精力进行真正的对齐,而不仅仅是试图优化用户参与度指标。

人生使命:AI安全

世界上真正致力于AI安全问题的人非常少。

即使现在,全球一年在AI基础设施上的资本开支已达3000亿美元,但真正全职研究「对齐问题」的人,Mann估计不到一千。这更坚定了他们「专注安全」的决心。

Mann曾担心,只要追求商业速度,就得牺牲安全。

但在Opus 3发布后,他意识到对齐研究反而让产品更具人格魅力,两者呈「互相加速」的凸性关系——越专注安全,模型越受欢迎。

Anthropic的绝招是「宪法式AI」:他们把联合国人权宣言、苹果隐私条款等原则写成自然语言清单,内嵌进模型。比起传统人工标注,让AI的价值观更系统,也减少了偏见。

初衷

把AI安全作为AI领域中一切工作的核心,这也和Mann阅读大量科幻小说有很大关系,这让他习惯于用一种面向未来、长期视角来看待世界。

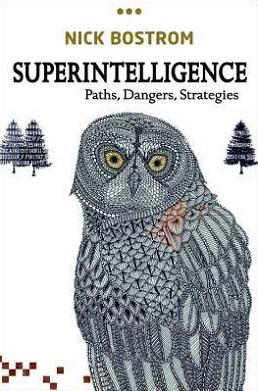

但真正让意识到这件事情的现实紧迫性,是在2016年左右他读了Nick Bostrom的《超级智能》(Superintelligence)。

那本书让他第一次深刻意识到,AI安全并不简单,可能是未来人类命运最关键的议题之一。

读完之后,他立刻决定加OpenAI,付诸行动。

最初,OpenAI并不清楚如何实现AGI。当时甚至设想过,或许需要一群强化学习(RL)智能体在一个孤岛上展开竞争,最终意识会自发地出现。

但自从语言模型取得了进展后,实现AGI的路径变得更加明确。

书中更多讨论的是:如何将「上帝」关在盒子里,避免它从盒子里逃脱。

现在,Mann觉得现实更讽刺:很多人反过来,主动把「上帝」请出盒子,还把银行账号交给它。

未雨绸缪

他并非全盘否定。Mann的安全哲学像「强制性登机检查」:

- 概率再小≠零:「1%坠机率的航班你敢坐吗?」 ASL-5警报:将AI风险分级为「致人死亡→灭绝人类」,对标核武器管控; 自曝家丑:Anthropic定期发布模型「犯罪记录」,哪怕暴露弱点——「行业进步需要真实代价」。

他的核心逻辑:「我们希望AI是救世主,但必须按它会是终结者来防备。」

现在的AI只是运行在计算机上,可能仅限于在网络上搜索东西,其潜在危害相对较小。但当AI进入到机器人和自主智能体时,才是最大的危险。

如果我们没有做好准备,问题就会变得极其严重。

奇点将至,Mann认为留给人类的时间不多了:

- 2024-2026:硬件成本骤降,人形机器人只剩两万美元,缺的只是大脑」; 2027-2028:按照最新报告《AI 2027》,奇点节点可能推迟到2028——但也只多争取了一年; 2030以后:若成功安全对齐,人类将进入「数据中心里的天才国度」;否者,后果难以估量;

真正的瓶颈:硅、算法与电

当同行沉迷于RLHF(人类反馈强化学习)时,Anthropic已升级到RLAIF:让AI自我批判与修正,效率超人工千倍——但若「自查机制」有盲区,等于「蒙眼开火箭」。

而当前最大瓶颈竟是物理限制:

- 算力饥荒:若有10倍电力,GPT-5明天就能问世; 硅的诅咒:7nm芯片的物理极限逼近,算法进步开始「挤牙膏」; 数据荒漠:高质量语料即将耗尽,AI可能陷入「自我抄袭循环」。

通过算法、数据和效率的改进,行业中单位智能的成本下降了10倍。

因此,拥有更多能做出更好研究的研究人员,找到如何进一步提升模型表现的路径,也是一个瓶颈。

参考资料

https://www.youtube.com/watch?v=WWoyWNhx2XU&t=1078s

本文来自微信公众号“新智元”,作者:KingHZ,36氪经授权发布。