Perplexity 每一次纳入新模型,都是很强的信号:这一次,亮的是 Kimi K2。7 月 13 日,Perplexity 联合创始人兼 CEO Aravind Srinivas 在 X 上发布消息:“Kimi K2 的内部评测结果非常惊艳,我们很快会启动 post-training。”

Perplexity的站台,让K2在开源社区的热度继续飙升,这种盛况并不陌生——上一次出现类似的轰动效应,正是Perplexity宣布选择纳入DeepSeek-R1的时候。

这背后反映出一个有趣的现象:对于全球开发者来说,Perplexity用不用某个开源模型,实际上已经演变成了一个重要的风向标。它所指向的,不仅仅是技术优劣,更是开源模型能否经受住真实产业环境考验的关键信号。

AI搜索是离“真实世界任务”最近的试炼场,而Perplexity对模型的需求远不止“便宜”这么简单。

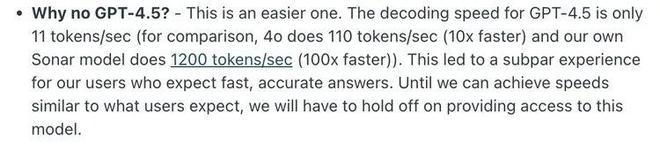

Aravind曾在Reddit上解释为什么没有接入GPT-4.5:“GPT-4.5的解码速度只有11个token/秒,相比之下,4o是110个token/秒(快10倍),我们自己的Sonar模型是1200个token/秒(快100倍)。这导致用户体验不佳,因为他们期望快速、准确的答案。”

换句话说,实时响应和低延迟是选型的生死线。Perplexity的峰值请求量可达日常十倍,任何超过两秒的等待都会显著降低用户体验。在vLLM + FP8实测中,K2的MoE架构仅激活32B参数,在相同硬件条件下输出速度比R1快一倍,且单位成本更低,这正是高并发场景下经济与性能的最佳平衡点。

今年4月,Aravind预告了Perplexity的系列新功能,他强调这不是简单的产品改动,而是底层模型的重构:“我们需要重写基础设施才能大规模实现。”

他描述的核心功能是更强大的深度研究代理,能够思考30分钟或更长时间,“包括工具使用、交互式和代码执行功能,就像Manus等最近的原型所展示的那样。”

这本质上是一个纯Agent模式:给定自然语言需求,模型必须自主拆解任务、调用工具、执行代码,最终生成完整报告。这种能力恰好与Kimi K2的“模型即Agent”理念完全对齐——K2不是把Agent能力当作后训练插件,而是在预训练阶段就将原生Agent技能刻入权重。

K2在训练阶段引入了数百万条合成Agent任务,覆盖搜索、浏览器、日历、Python、SQL等17种真实工具调用场景。模型学会在单一会话内连续编排16-20步操作,无需人类编写工作流。官方演示中,K2用16次IPython调用将13万行原始数据完成清洗、建模、绘图并输出交互网页报告,全程零人工干预——这直接对应Perplexity设想的“30分钟自主研究”。

当然,选择开源模型的更深层原因在于完整的控制权。拥有完整权重意味着Perplexity可以任意进行LoRA、RLHF、工具蒸馏,无需担心调用频率、并发上限或隐私合规问题。K2采用MIT改协议,月活低于1亿即可商用,Hugging Face直接提供fp8/fp16全套权重,128K上下文窗口足够一次性处理整份财报。对Perplexity而言,这意味着“模型-索引-工具”三层架构可以完全私有化,不再受任何闭源条款约束。

Perplexity 在其发展过程中,逐步从依赖 OpenAI 的 GPT 模型转向使用开源模型,并在此基础上进行了自研和微调。

2023年下半年,Perplexity 宣布推出两款新的“pplx-7b-online”和“pplx-70b-online”,分别基于开源模型 Mistral-7b 和 LLaMA 2-70b 构建。“我们从LLaMA-2发布之日起就开始使用开源模型,”Aravind Srinivas说道。

从模型特点来看,Mistral-7B以轻量化和高速度成为早期尝试,验证了小模型在特定任务的可行性;Llama-2-70B提供了更广的知识覆盖面;随后,Perplexity还采用了Code Llama-34B,补强了代码相关的垂直能力。

真正的转折点出现在2025年2月,DeepSeek-R1让Perplexity完成了从“使用开源模型”到“基于开源模型自研”的关键跳跃,获得了完整的权重控制能力。而后,Perplexity又继续深度调优Sonar模型,展现了自研能力的成熟,专门针对搜索问答场景进行优化。

如今选择Kimi K2,正是这一战略的最新体现——不仅在速度和成本上优于R1,其原生Agent能力更完美契合了“30分钟自主研究”的产品需求。

综合来看,Perplexity的模型选型必须在高性价比与高性能之间找到平衡,同时满足特定的产品需求。由于目前尚无开源模型能完全达到其标准,Perplexity只能阶段性地选择最优解,这种“择优而用”的策略反而让其成为了开源模型能力评判的重要风向标。